From Wikipedia, the free encyclopedia

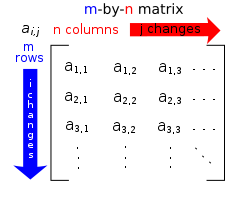

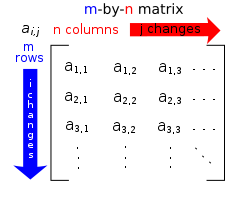

Specific entries of a matrix are often referenced by using pairs of subscripts.

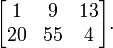

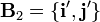

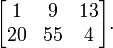

In mathematics, a matrix (plural matrices, or less commonly matrixes) is a rectangular array of numbers, such as

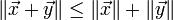

An item in a matrix is called an entry or an element. The example has entries 1, 9, 13, 20, 55, and 4. Entries are often denoted by a variable with two subscripts, as shown on the right. Matrices of the same size can be added and subtracted entrywise and matrices of compatible sizes can be multiplied. These operations have many of the properties of ordinary arithmetic, except that matrix multiplication is not commutative, that is, AB and BA are not equal in general. Matrices consisting of only one column or row define the components of vectors, while higher-dimensional (e.g., three-dimensional) arrays of numbers define the components of a generalization of a vector called a tensor. Matrices with entries in other fields or rings are also studied.

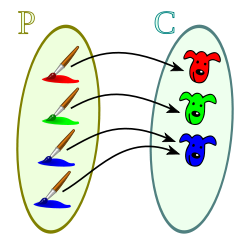

Matrices are a key tool in linear algebra. One use of matrices is to represent linear transformations, which are higher-dimensional analogs of linear functions of the form f(x) = cx, where c is a constant; matrix multiplication corresponds to composition of linear transformations. Matrices can also keep track of the coefficients in a system of linear equations. For a square matrix, the determinant and inverse matrix (when it exists) govern the behavior of solutions to the corresponding system of linear equations, and eigenvalues and eigenvectors provide insight into the geometry of the associated linear transformation.

Matrices find many applications. Physics makes use of matrices in various domains, for example in geometrical optics and matrix mechanics; the latter led to studying in more detail matrices with an infinite number of rows and columns. Graph theory uses matrices to keep track of distances between pairs of vertices in a graph. Computer graphics uses matrices to project 3-dimensional space onto a 2-dimensional screen. Matrix calculus generalizes classical analytical notions such as derivatives of functions or exponentials to matrices. The latter is a recurring need in solving ordinary differential equations. Serialism and dodecaphonism are musical movements of the 20th century that use a square mathematical matrix to determine the pattern of music intervals.

A major branch of numerical analysis is devoted to the development of efficient algorithms for matrix computations, a subject that is centuries old but still an active area of research. Matrix decomposition methods simplify computations, both theoretically and practically. For sparse matrices, specifically tailored algorithms can provide speedups; such matrices arise in the finite element method, for example.

[edit] Definition

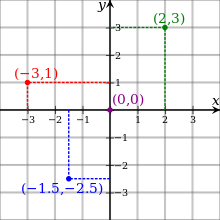

A matrix is a rectangular arrangement of numbers.[1] For example,

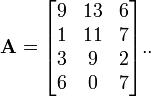

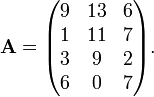

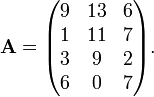

An alternative notation uses large parentheses instead of box brackets:

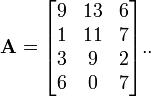

The horizontal and vertical lines in a matrix are called rows and columns, respectively. The numbers in the matrix are called its entries or its elements. To specify a matrix's size, a matrix with m rows and n columns is called an m-by-n matrix or m × n matrix, while m and n are called its dimensions. The above is a 4-by-3 matrix.

A matrix with one row (a 1 × n matrix) is called a row vector, and a matrix with one column (an m × 1 matrix) is called a column vector. Any row or column of a matrix determines a row or column vector, obtained by removing all other rows respectively columns from the matrix. For example, the row vector for the third row of the above matrix A is

When a row or column of a matrix is interpreted as a value, this refers to the corresponding row or column vector. For instance one may say that two different rows of a matrix are equal, meaning they determine the same row vector. In some cases the value of a row or column should be interpreted just as a sequence of values (an element of Rn if entries are real numbers) rather than as a matrix, for instance when saying that the rows of a matrix are equal to the corresponding columns of its transpose matrix.

Most of this article focuses on real and complex matrices, i.e., matrices whose entries are real or complex numbers. More general types of entries are discussed below.

[edit] Notation

The specifics of matrices notation varies widely, with some prevailing trends. Matrices are usually denoted using upper-case letters, while the corresponding lower-case letters, with two subscript indices, represent the entries. In addition to using upper-case letters to symbolize matrices, many authors use a special typographical style, commonly boldface upright (non-italic), to further distinguish matrices from other variables. An alternative notation involves the use of a double-underline with the variable name, with or without boldface style, (e.g.,  ).

).

The entry that lies in the i-th row and the j-th column of a matrix is typically referred to as the i,j, (i,j), or (i,j)th entry of the matrix. For example, the (2,3) entry of the above matrix A is 7. The (i, j)th entry of a matrix A is most commonly written as ai,j. Alternative notations for that entry are A[i,j] or Ai,j.

Sometimes a matrix is referred to by giving a formula for its (i,j)th entry, often with double parenthesis around the formula for the entry, for example, if the (i,j)th entry of A were given by aij, A would be denoted ((aij)).

An asterisk is commonly used to refer to whole rows or columns in a matrix. For example, ai,∗ refers to the ith row of A, and a∗,j refers to the jth column of A. The set of all m-by-n matrices is denoted  (m, n).

(m, n).

A common shorthand is

A = [

ai,j]

i=1,...,m; j=1,...,n or more briefly

A = [

ai,j]

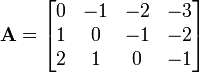

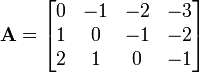

m×nto define an m × n matrix A. Usually the entries ai,j are defined separately for all integers 1 ≤ i ≤ m and 1 ≤ j ≤ n. They can however sometimes be given by one formula; for example the 3-by-4 matrix

can alternatively be specified by A = [i − j]i=1,2,3; j=1,...,4, or simply A = ((i-j)), where the size of the matrix is understood.

Some programming languages start the numbering of rows and columns at zero, in which case the entries of an m-by-n matrix are indexed by 0 ≤ i ≤ m − 1 and 0 ≤ j ≤ n − 1.[2] This article follows the more common convention in mathematical writing where enumeration starts from 1.

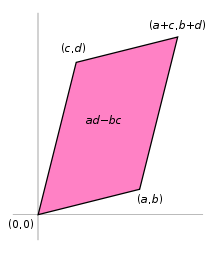

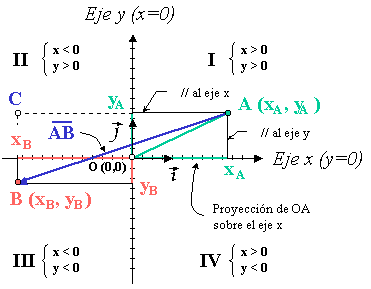

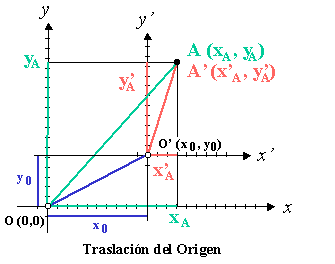

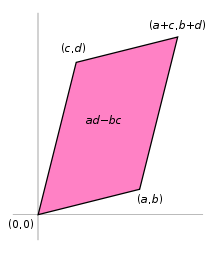

[edit] Interpretation as a parallelogram

The vectors represented by a matrix can be thought of as the sides of a unit square transformed into a parallelogram. The area of this parallelogram is the absolute value of the determinant of the matrix.

If A is a 2×2 matrix

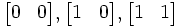

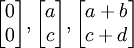

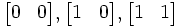

then the matrix A can be viewed as the transform of the unit square into a parallelogram with vertices at (0,0), (a,b), (a + c, b + d), and (c,d). The assumption here is that a linear transformation is applied to row vectors as the vector-matrix product xTAT, where x is a column vector. The parallelogram in the figure is obtained by multiplying matrix A (which stores the co-ordinates of our parallelogram) with each of the row vectors  and

and  in turn. These row vectors define the vertices of the unit square. With the more common matrix-vector product Ax, the parallelogram has vertices at

in turn. These row vectors define the vertices of the unit square. With the more common matrix-vector product Ax, the parallelogram has vertices at  and

and  (note that Ax = (xTAT)T ).

(note that Ax = (xTAT)T ).

Further, the area of this parallelogram can be viewed as the absolute value of the determinant of the matrix A. When the determinant is equal to one, then the matrix represents an equi-areal mapping.

[edit] Basic operations

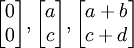

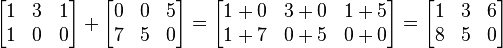

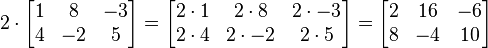

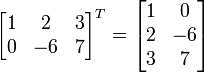

There are a number of operations that can be applied to modify matrices called matrix addition, scalar multiplication and transposition.[3] These form the basic techniques to deal with matrices.

Familiar properties of numbers extend to these operations of matrices: for example, addition is commutative, i.e. the matrix sum does not depend on the order of the summands: A + B = B + A.[4] The transpose is compatible with addition and scalar multiplication, as expressed by (cA)T = c(AT) and (A + B)T = AT + BT. Finally, (AT)T = A.

Row operations are ways to change matrices. There are three types of row operations: row switching, that is interchanging two rows of a matrix, row multiplication, multiplying all entries of a row by a non-zero constant and finally row addition which means adding a multiple of a row to another row. These row operations are used in a number of ways including solving linear equations and finding inverses.

[edit] Matrix multiplication, linear equations and linear transformations

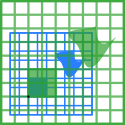

Schematic depiction of the matrix product

AB of two matrices

A and

B.

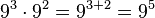

Multiplication of two matrices is defined only if the number of columns of the left matrix is the same as the number of rows of the right matrix. If A is an m-by-n matrix and B is an n-by-p matrix, then their matrix product AB is the m-by-p matrix whose entries are given by dot-product of the corresponding row of A and the corresponding column of B:

![[mathbf{AB}]_{i,j} = A_{i,1}B_{1,j} + A_{i,2}B_{2,j} + cdots + A_{i,n}B_{n,j} = sum_{r=1}^n A_{i,r}B_{r,j},](https://petalofucsia.blogia.com/upload/externo-3ca8439caa54b4695f0cd2ea32e5115e.png)

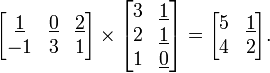

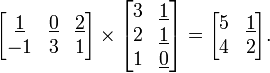

where 1 ≤ i ≤ m and 1 ≤ j ≤ p.[5] For example (the underlined entry 1 in the product is calculated as the product 1 · 1 + 0 · 1 + 2 · 0 = 1):

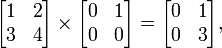

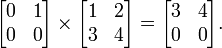

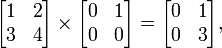

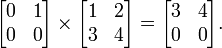

Matrix multiplication satisfies the rules (AB)C = A(BC) (associativity), and (A+B)C = AC+BC as well as C(A+B) = CA+CB (left and right distributivity), whenever the size of the matrices is such that the various products are defined.[6] The product AB may be defined without BA being defined, namely if A and B are m-by-n and n-by-k matrices, respectively, and m ≠ k. Even if both products are defined, they need not be equal, i.e. generally one has

AB ≠

BA,

i.e., matrix multiplication is not commutative, in marked contrast to (rational, real, or complex) numbers whose product is independent of the order of the factors. An example of two matrices not commuting with each other is:

whereas

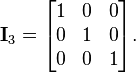

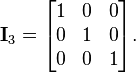

The identity matrix In of size n is the n-by-n matrix in which all the elements on the main diagonal are equal to 1 and all other elements are equal to 0, e.g.

It is called identity matrix because multiplication with it leaves a matrix unchanged: MIn = ImM = M for any m-by-n matrix M.

Besides the ordinary matrix multiplication just described, there exist other less frequently used operations on matrices that can be considered forms of multiplication, such as the Hadamard product and the Kronecker product.[7] They arise in solving matrix equations such as the Sylvester equation.

[edit] Linear equations

A particular case of matrix multiplication is tightly linked to linear equations: if x designates a column vector (i.e. n×1-matrix) of n variables x1, x2, ..., xn, and A is an m-by-n matrix, then the matrix equation

Ax =

b,

where b is some m×1-column vector, is equivalent to the system of linear equations

A1,1x1 +

A1,2x2 + ... +

A1,nxn =

b1...

Am,1x1 +

Am,2x2 + ... +

Am,nxn =

bm .

[8]This way, matrices can be used to compactly write and deal with multiple linear equations, i.e. systems of linear equations.

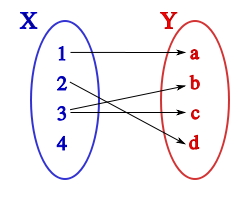

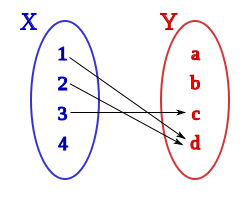

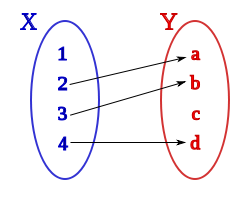

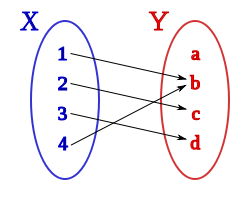

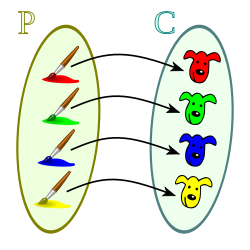

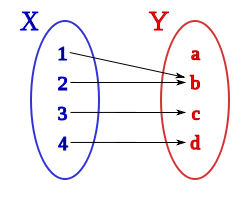

[edit] Linear transformations

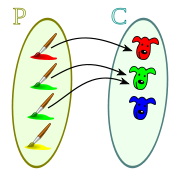

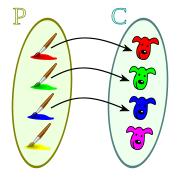

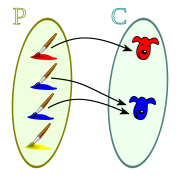

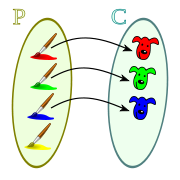

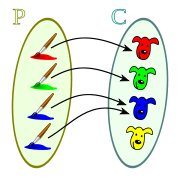

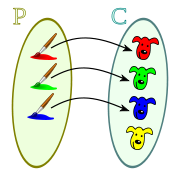

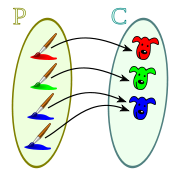

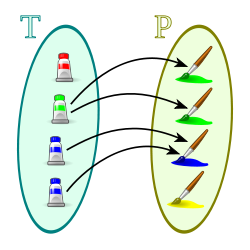

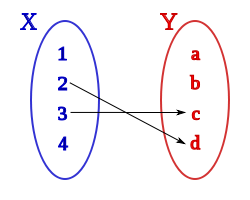

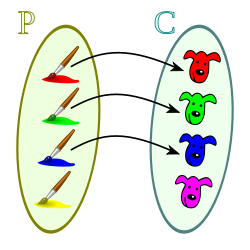

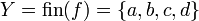

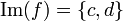

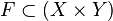

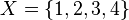

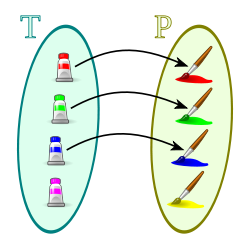

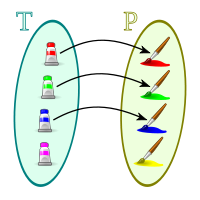

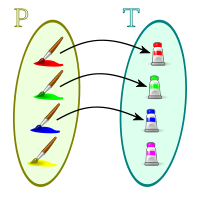

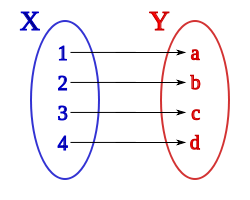

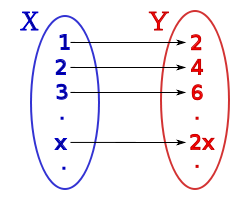

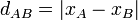

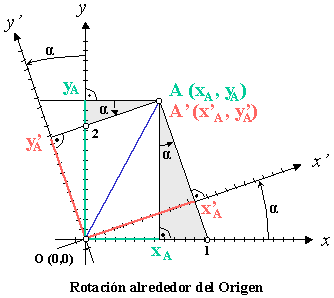

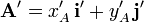

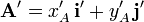

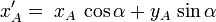

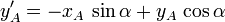

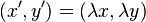

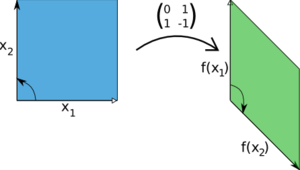

Matrices and matrix multiplication reveal their essential features when related to linear transformations, also known as linear maps. A real m-by-n matrix A gives rise to a linear transformation Rn → Rm mapping each vector x in Rn to the (matrix) product Ax, which is a vector in Rm. Conversely, each linear transformation f: Rn → Rm arises from a unique m-by-n matrix A: explicitly, the (i, j)-entry of A is the ith coordinate of f(ej), where ej = (0,...,0,1,0,...,0) is the unit vector with 1 in the jth position and 0 elsewhere. The matrix A is said to represent the linear map f, and A is called the transformation matrix of f.

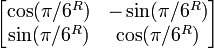

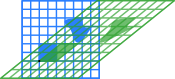

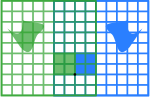

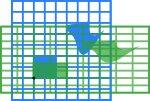

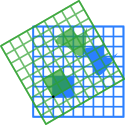

The following table shows a number of 2-by-2 matrices with the associated linear maps of R2. The blue original is mapped to the green grid and shapes, the origin (0,0) is marked with a black point.

Under the 1-to-1 correspondence between matrices and linear maps, matrix multiplication corresponds to composition of maps:[9] if a k-by-m matrix B represents another linear map g : Rm → Rk, then the composition g ∘ f is represented by BA since

(

g ∘

f)(

x) =

g(

f(

x)) =

g(

Ax) =

B(

Ax) = (

BA)

x.

The last equality follows from the above-mentioned associativity of matrix multiplication.

The rank of a matrix A is the maximum number of linearly independent row vectors of the matrix, which is the same as the maximum number of linearly independent column vectors.[10] Equivalently it is the dimension of the image of the linear map represented by A.[11] The rank-nullity theorem states that the dimension of the kernel of a matrix plus the rank equals the number of columns of the matrix.[12]

[edit] Square matrices

A square matrix is a matrix which has the same number of rows and columns. An n-by-n matrix is known as a square matrix of order n. Any two square matrices of the same order can be added and multiplied. A square matrix A is called invertible or non-singular if there exists a matrix B such that

AB =

In.

[13]This is equivalent to BA = In.[14] Moreover, if B exists, it is unique and is called the inverse matrix of A, denoted A−1.

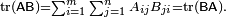

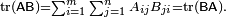

The entries Ai,i form the main diagonal of a matrix. The trace, tr(A) of a square matrix A is the sum of its diagonal entries. While, as mentioned above, matrix multiplication is not commutative, the trace of the product of two matrices is independent of the order of the factors: tr(AB) = tr(BA).[15]

Also, the trace of a matrix is equal to that of its transpose, i.e. tr(A) = tr(AT).

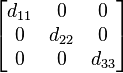

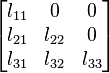

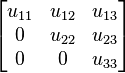

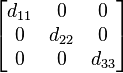

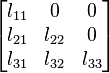

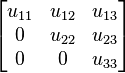

If all entries outside the main diagonal are zero, A is called a diagonal matrix. If only all entries above (below) the main diagonal are zero, A is called a lower triangular matrix (upper triangular matrix, respectively). For example, if n = 3, they look like

(diagonal),

(lower) and

(upper triangular matrix).

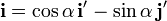

[edit] Determinant

Main article:

Determinant

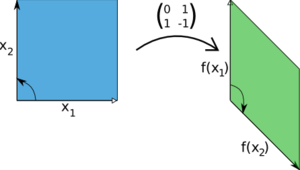

A linear transformation on

R2 given by the indicated matrix. The determinant of this matrix is −1, as the area of the green parallelogram at the right is 1, but the map reverses the

orientation, since it turns the counterclockwise orientation of the vectors to a clockwise one.

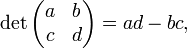

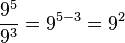

The determinant det(A) or |A| of a square matrix A is a number encoding certain properties of the matrix. A matrix is invertible if and only if its determinant is nonzero. Its absolute value equals the area (in R2) or volume (in R3) of the image of the unit square (or cube), while its sign corresponds to the orientation of the corresponding linear map: the determinant is positive if and only if the orientation is preserved.

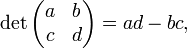

The determinant of 2-by-2 matrices is given by

the determinant of 3-by-3 matrices involves 6 terms (rule of Sarrus). The more lengthy Leibniz formula generalises these two formulae to all dimensions.[16]

The determinant of a product of square matrices equals the product of their determinants: det(AB) = det(A) · det(B).[17] Adding a multiple of any row to another row, or a multiple of any column to another column, does not change the determinant. Interchanging two rows or two columns affects the determinant by multiplying it by −1.[18] Using these operations, any matrix can be transformed to a lower (or upper) triangular matrix, and for such matrices the determinant equals the product of the entries on the main diagonal; this provides a method to calculate the determinant of any matrix. Finally, the Laplace expansion expresses the determinant in terms of minors, i.e., determinants of smaller matrices.[19] This expansion can be used for a recursive definition of determinants (taking as starting case the determinant of a 1-by-1 matrix, which is its unique entry, or even the determinant of a 0-by-0 matrix, which is 1), that can be seen to be equivalent to the Leibniz formula. Determinants can be used to solve linear systems using Cramer's rule, where the division of the determinants of two related square matrices equates to the value of each of the system's variables.[20]

[edit] Eigenvalues and eigenvectors

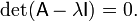

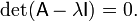

A number λ and a non-zero vector v satisfying

Av = λ

vare called an eigenvalue and an eigenvector of A, respectively.[nb 1][21] The number λ is an eigenvalue of an n×n-matrix A if and only if A−λIn is not invertible, which is equivalent to

[22]

[22]The function pA(t) = det(A−tI) is called the characteristic polynomial of A, its degree is n. Therefore pA(t) has at most n different roots, i.e., eigenvalues of the matrix.[23] They may be complex even if the entries of A are real. According to the Cayley-Hamilton theorem, pA(A) = 0, that is to say, the characteristic polynomial applied to the matrix itself yields the zero matrix.

[edit] Symmetry

A square matrix A that is equal to its transpose, i.e. A = AT, is a symmetric matrix. If instead, A was equal to the negative of its transpose, i.e. A = −AT, then A is a skew-symmetric matrix. In complex matrices, symmetry is often replaced by the concept of Hermitian matrices, which satisfy A∗ = A, where the star or asterisk denotes the conjugate transpose of the matrix, i.e. the transpose of the complex conjugate of A.

By the spectral theorem, real symmetric matrices and complex Hermitian matrices have an eigenbasis; i.e., every vector is expressible as a linear combination of eigenvectors. In both cases, all eigenvalues are real.[24] This theorem can be generalized to infinite-dimensional situations related to matrices with infinitely many rows and columns, see below.

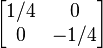

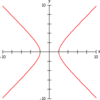

[edit] Definiteness

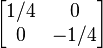

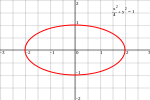

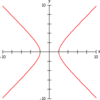

Matrix A; definiteness; associated quadratic form QA(x,y);

set of vectors (x,y) such that QA(x,y)=1 |

|  |

| positive definite | indefinite |

| 1/4 x2 + y2 | 1/4 x2 − 1/4 y2 |

Ellipse |

Hyperbola |

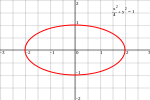

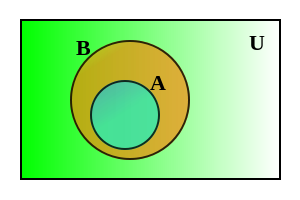

A symmetric n×n-matrix is called positive-definite (respectively negative-definite; indefinite), if for all nonzero vectors x ∈ Rn the associated quadratic form given by

Q(x) = xTAxtakes only positive values (respectively only negative values; both some negative and some positive values).[25] If the quadratic form takes only non-negative (respectively only non-positive) values, the symmetric matrix is called positive-semidefinite (respectively negative-semidefinite); hence the matrix is indefinite precisely when it is neither positive-semidefinite nor negative-semidefinite.

A symmetric matrix is positive-definite if and only if all its eigenvalues are positive.[26] The table at the right shows two possibilities for 2-by-2 matrices.

Allowing as input two different vectors instead yields the bilinear form associated to A:

BA (

x,

y) =

xTAy.

[27][edit] Computational aspects

In addition to theoretical knowledge of properties of matrices and their relation to other fields, it is important for practical purposes to perform matrix calculations effectively and precisely. The domain studying these matters is called numerical linear algebra.[28] As with other numerical situations, two main aspects are the complexity of algorithms and their numerical stability. Many problems can be solved by both direct algorithms or iterative approaches. For example, finding eigenvectors can be done by finding a sequence of vectors xn converging to an eigenvector when n tends to infinity.[29]

Determining the complexity of an algorithm means finding upper bounds or estimates of how many elementary operations such as additions and multiplications of scalars are necessary to perform some algorithm, e.g. multiplication of matrices. For example, calculating the matrix product of two n-by-n matrix using the definition given above needs n3 multiplications, since for any of the n2 entries of the product, n multiplications are necessary. The Strassen algorithm outperforms this "naive" algorithm; it needs only n2.807 multiplications.[30] A refined approach also incorporates specific features of the computing devices.

In many practical situations additional information about the matrices involved is known. An important case are sparse matrices, i.e. matrices most of whose entries are zero. There are specifically adapted algorithms for, say, solving linear systems Ax = b for sparse matrices A, such as the conjugate gradient method.[31]

An algorithm is, roughly speaking, numerically stable, if little deviations (such as rounding errors) do not lead to big deviations in the result. For example, calculating the inverse of a matrix via Laplace's formula (Adj (A) denotes the adjugate matrix of A)

A−1 = Adj(

A) / det(

A)

may lead to significant rounding errors if the determinant of the matrix is very small. The norm of a matrix can be used to capture the conditioning of linear algebraic problems, such as computing a matrix' inverse.[32]

Although most computer languages are not designed with commands or libraries for matrices, as early as the 1970s, some engineering desktop computers such as the HP 9830 had ROM cartridges to add BASIC commands for matrices. Some computer languages such as APL were designed to manipulate matrices, and various mathematical programs can be used to aid computing with matrices.[33]

[edit] Matrix decomposition methods

There are several methods to render matrices into a more easily accessible form. They are generally referred to as matrix transformation or matrix decomposition techniques. The interest of all these decomposition techniques is that they preserve certain properties of the matrices in question, such as determinant, rank or inverse, so that these quantities can be calculated after applying the transformation, or that certain matrix operations are algorithmically easier to carry out for some types of matrices.

The LU decomposition factors matrices as a product of lower (L) and an upper triangular matrices (U).[34] Once this decomposition is calculated, linear systems can be solved more efficiently, by a simple technique called forward and back substitution. Likewise, inverses of triangular matrices are algorithmically easier to calculate. The Gaussian elimination is a similar algorithm; it transforms any matrix to row echelon form.[35] Both methods proceed by multiplying the matrix by suitable elementary matrices, which correspond to permuting rows or columns and adding multiples of one row to another row. Singular value decomposition expresses any matrix A as a product UDV∗, where U and V are unitary matrices and D is a diagonal matrix.

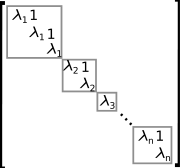

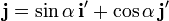

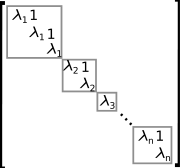

A matrix in Jordan normal form. The grey blocks are called Jordan blocks.

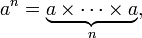

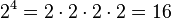

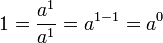

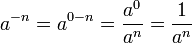

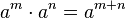

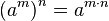

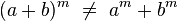

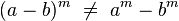

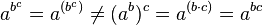

The eigendecomposition or diagonalization expresses A as a product VDV−1, where D is a diagonal matrix and V is a suitable invertible matrix.[36] If A can be written in this form, it is called diagonalizable. More generally, and applicable to all matrices, the Jordan decomposition transforms a matrix into Jordan normal form, that is to say matrices whose only nonzero entries are the eigenvalues λ1 to λn of A, placed on the main diagonal and possibly entries equal to one directly above the main diagonal, as shown at the right.[37] Given the eigendecomposition, the nth power of A (i.e. n-fold iterated matrix multiplication) can be calculated via

An = (

VDV−1)

n =

VDV−1VDV−1...

VDV−1 =

VDnV−1and the power of a diagonal matrix can be calculated by taking the corresponding powers of the diagonal entries, which is much easier than doing the exponentiation for A instead. This can be used to compute the matrix exponential eA, a need frequently arising in solving linear differential equations, matrix logarithms and square roots of matrices.[38] To avoid numerically ill-conditioned situations, further algorithms such as the Schur decomposition can be employed.[39]

[edit] Abstract algebraic aspects and generalizations

Matrices can be generalized in different ways. Abstract algebra uses matrices with entries in more general fields or even rings, while linear algebra codifies properties of matrices in the notion of linear maps. It is possible to consider matrices with infinitely many columns and rows. Another extension are tensors, which can be seen as higher-dimensional arrays of numbers, as opposed to vectors, which can often be realised as sequences of numbers, while matrices are rectangular or two-dimensional array of numbers.[40] Matrices, subject to certain requirements tend to form groups known as matrix groups.

[edit] Matrices with more general entries

This article focuses on matrices whose entries are real or complex numbers. However, matrices can be considered with much more general types of entries than real or complex numbers. As a first step of generalization, any field, i.e. a set where addition, subtraction, multiplication and division operations are defined and well-behaved, may be used instead of R or C, for example rational numbers or finite fields. For example, coding theory makes use of matrices over finite fields. Wherever eigenvalues are considered, as these are roots of a polynomial they may exist only in a larger field than that of the coefficients of the matrix; for instance they may be complex in case of a matrix with real entries. The possibility to reinterpret the entries of a matrix as elements of a larger field (e.g., to view a real matrix as a complex matrix whose entries happen to be all real) then allows considering each square matrix to possess a full set of eigenvalues. Alternatively one can consider only matrices with entries in an algebraically closed field, such as C, from the outset.

More generally, abstract algebra makes great use of matrices with entries in a ring R.[41] Rings are a more general notion than fields in that no division operation exists. The very same addition and multiplication operations of matrices extend to this setting, too. The set M(n, R) of all square n-by-n matrices over R is a ring called matrix ring, isomorphic to the endomorphism ring of the left R-module Rn.[42] If the ring R is commutative, i.e., its multiplication is commutative, then M(n, R) is a unitary noncommutative (unless n = 1) associative algebra over R. The determinant of square matrices over a commutative ring R can still be defined using the Leibniz formula; such a matrix is invertible if and only if its determinant is invertible in R, generalising the situation over a field F, where every nonzero element is invertible.[43] Matrices over superrings are called supermatrices.[44]

Matrices do not always have all their entries in the same ring - or even in any ring at all. One special but common case is block matrices, which may be considered as matrices whose entries themselves are matrices. The entries need not be quadratic matrices, and thus need not be members of any ordinary ring; but their sizes must fulfil certain compatibility conditions.

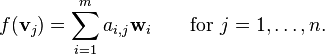

[edit] Relationship to linear maps

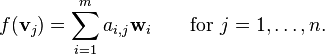

Linear maps Rn → Rm are equivalent to m-by-n matrices, as described above. More generally, any linear map f: V → W between finite-dimensional vector spaces can be described by a matrix A = (aij), after choosing bases v1, ..., vn of V, and w1, ..., wm of W (so n is the dimension of V and m is the dimension of W), which is such that

In other words, column j of A expresses the image of vj in terms of the basis vectors wi of W; thus this relation uniquely determines the entries of the matrix A. Note that the matrix depends on the choice of the bases: different choices of bases give rise to different, but equivalent matrices.[45] Many of the above concrete notions can be reinterpreted in this light, for example, the transpose matrix AT describes the transpose of the linear map given by A, with respect to the dual bases.[46]

[edit] Matrix groups

Main article:

Matrix groupA group is a mathematical structure consisting of a set of objects together with a binary operation, i.e. an operation combining any two objects to a third, subject to certain requirements.[47] A group in which the objects are matrices and the group operation is matrix multiplication is called a matrix group.[nb 2][48] Since in a group every element has to be invertible, the most general matrix groups are the groups of all invertible matrices of a given size, called the general linear groups.

Any property of matrices that is preserved under matrix products and inverses can be used to define further matrix groups. For example, matrices with a given size and with a determinant of 1 form a subgroup of (i.e. a smaller group contained in) their general linear group, called a special linear group.[49] Orthogonal matrices, determined by the condition

MTM =

I,

form the orthogonal group.[50] They are called orthogonal since the associated linear transformations of Rn preserve angles in the sense that the scalar product of two vectors is unchanged after applying M to them:

(

Mv) · (

Mw) =

v ·

w.

[51]Every finite group is isomorphic to a matrix group, as one can see by considering the regular representation of the symmetric group.[52] General groups can be studied using matrix groups, which are comparatively well-understood, by means of representation theory.[53]

[edit] Infinite matrices

It is also possible to consider matrices with infinitely many rows and/or columns[54] even if, being infinite objects, one cannot write down such matrices explicitly. All that matters is that for every element in the set indexing rows, and every element in the set indexing columns, there is a well-defined entry (these index sets need not even be subsets of the natural numbers). The basic operations of addition, subtraction, scalar multiplication and transposition can still be defined without problem; however matrix multiplication may involve infinite summations to define the resulting entries, and these are not defined in general.

If infinite matrices are used to describe linear maps, then only those matrices can be used all of whose columns have but a finite number of nonzero entries, for the following reason. For a matrix A to describe a linear map f: V→W, bases for both spaces must have been chosen; recall that by definition this means that every vector in the space can be written uniquely as a (finite) linear combination of basis vectors, so that written as a (column) vector v of coefficients, only finitely many entries vi are nonzero. Now the columns of A describe the images by f of individual basis vectors of V in the basis of W, which is only meaningful if these columns have only finitely many nonzero entries. There is no restriction on the rows of A however: in the product A·v there are only finitely many nonzero coefficients of v involved, so every one of its entries, even if it is given as an infinite sum of products, involves only finitely many nonzero terms and is therefore well defined. Moreover this amounts to forming a linear combination of the columns of A that effectively involves only finitely many of them, whence the result has only finitely many nonzero entries, because each of those columns do. One also sees that products of two matrices of the given type is well defined (provided as usual that the column-index and row-index sets match), is again of the same type, and corresponds to the composition of linear maps.

Infinite matrices can also be used to describe operators on Hilbert spaces, where convergence and continuity questions arise, which again results in certain constraints that have to be imposed. However, the explicit point of view of matrices tends to obfuscate the matter,[nb 3] and the abstract and more powerful tools of functional analysis can be used instead.

[edit] Empty matrices

An empty matrix is a matrix in which the number of rows or columns (or both) is zero.[55][56] An empty matrix has no entries but it still has a well defined number of rows and columns, which are needed for instance in the definition of the matrix product. Thus if A is the 3-by-0 matrix A and B is the 0-by-3 matrix B, then AB is the 3-by-3 zero matrix (corresponding to the null map from a 3-dimensional space V to itself obtained obtained as composition  of the unique map f from V to a 0-dimensional space Z, followed by the zero map g from Z back to V), while BA is the 0-by-0 matrix (corresponding to the unique map from Z to itself obtained as composition

of the unique map f from V to a 0-dimensional space Z, followed by the zero map g from Z back to V), while BA is the 0-by-0 matrix (corresponding to the unique map from Z to itself obtained as composition  ). There is no common notation for empty matrices but most computer algebra systems will allow creating them and computing with them. Note that the determinant of the 0-by-0 matrix is 1 (and not 0 as might seem more natural): the Leibniz formula produces this value as a sum over the unique permutation of the empty set, with an empty product as term; also the Laplace expansion for a 1-by-1 matrix makes clear that the value of the 0-by-0 minor should be taken to be 1. This value is also consistent with the fact that the identity map from any finite dimensional space to itself has determinant 1, a fact that is often used as a part of the characterization of determinants.

). There is no common notation for empty matrices but most computer algebra systems will allow creating them and computing with them. Note that the determinant of the 0-by-0 matrix is 1 (and not 0 as might seem more natural): the Leibniz formula produces this value as a sum over the unique permutation of the empty set, with an empty product as term; also the Laplace expansion for a 1-by-1 matrix makes clear that the value of the 0-by-0 minor should be taken to be 1. This value is also consistent with the fact that the identity map from any finite dimensional space to itself has determinant 1, a fact that is often used as a part of the characterization of determinants.

[edit] Applications

There are numerous applications of matrices, both in mathematics and other sciences. Some of them merely take advantage of the compact representation of a set of numbers in a matrix. For example, in game theory and economics, the payoff matrix encodes the payoff for two players, depending on which out of a given (finite) set of alternatives the players choose.[57] Text mining and automated thesaurus compilation makes use of document-term matrices such as tf-idf in order to keep track of frequencies of certain words in several documents.[58]

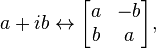

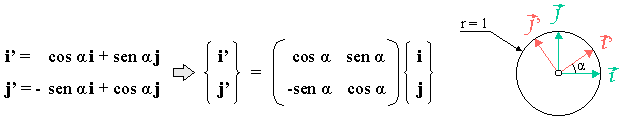

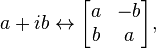

Complex numbers can be represented by particular real 2-by-2 matrices via

under which addition and multiplication of complex numbers and matrices correspond to each other. For example, 2-by-2 rotation matrices represent the multiplication with some complex number of absolute value 1, as above. A similar interpretation is possible for quaternions.[59]

Early encryption techniques such as the Hill cipher also used matrices. However, due to the linear nature of matrices, these codes are comparatively easy to break.[60] Computer graphics uses matrices both to represent objects and to calculate transformations of objects using affine rotation matrices to accomplish tasks such as projecting a three-dimensional object onto a two-dimensional screen, corresponding to a theoretical camera observation.[61] Matrices over a polynomial ring are important in the study of control theory.

Chemistry makes use of matrices in various ways, particularly since the use of quantum theory to discuss molecular bonding and spectroscopy. Examples are the overlap matrix and the Fock matrix using in solving the Roothaan equations to obtain the molecular orbitals of the Hartree–Fock method.

[edit] Graph theory

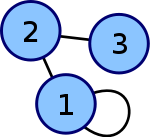

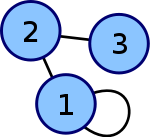

An undirected graph with adjacency matrix

The adjacency matrix of a finite graph is a basic notion of graph theory.[62] It saves which vertices of the graph are connected by an edge. Matrices containing just two different values (0 and 1 meaning for example "yes" and "no") are called logical matrices. The distance (or cost) matrix contains information about distances of the edges.[63] These concepts can be applied to websites connected hyperlinks or cities connected by roads etc., in which case (unless the road network is extremely dense) the matrices tend to be sparse, i.e. contain few nonzero entries. Therefore, specifically tailored matrix algorithms can be used in network theory.

[edit] Analysis and geometry

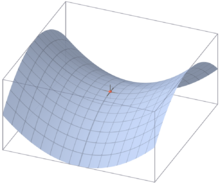

The Hessian matrix of a differentiable function ƒ: Rn → R consists of the second derivatives of ƒ with respect to the several coordinate directions, i.e.[64]

![H(f) = left [frac {partial^2f}{partial x_i , partial x_j} right ].](https://petalofucsia.blogia.com/upload/externo-58a5cf41ace9dfbc6707fc07e931e7ca.png)

It encodes information about the local growth behaviour of the function: given a critical point x = (x1, ..., xn), i.e., a point where the first partial derivatives  of ƒ vanish, the function has a local minimum if the Hessian matrix is positive definite. Quadratic programming can be used to find global minima or maxima of quadratic functions closely related to the ones attached to matrices (see above).[65]

of ƒ vanish, the function has a local minimum if the Hessian matrix is positive definite. Quadratic programming can be used to find global minima or maxima of quadratic functions closely related to the ones attached to matrices (see above).[65]

Another matrix frequently used in geometrical situations is the Jacobi matrix of a differentiable map f: Rn → Rm. If f1, ..., fm denote the components of f, then the Jacobi matrix is defined as [66]

![J(f) = left [frac {partial f_i}{partial x_j} right ]_{1 leq i leq m, 1 leq j leq n}.](https://petalofucsia.blogia.com/upload/externo-cd2e1dff21dc4c322bc92b6d1911915c.png)

If n > m, and if the rank of the Jacobi matrix attains its maximal value m, f is locally invertible at that point, by the implicit function theorem.[67]

Partial differential equations can be classified by considering the matrix of coefficients of the highest-order differential operators of the equation. For elliptic partial differential equations this matrix is positive definite, which has decisive influence on the set of possible solutions of the equation in question.[68]

The finite element method is an important numerical method to solve partial differential equations, widely applied in simulating complex physical systems. It attempts to approximate the solution to some equation by piecewise linear functions, where the pieces are chosen with respect to a sufficiently fine grid, which in turn can be recast as a matrix equation.[69]

[edit] Probability theory and statistics

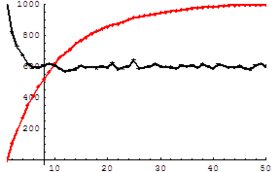

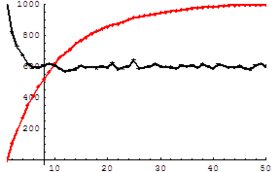

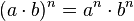

Two different Markov chains. The chart depicts the number of particles (of a total of 1000) in state "2". Both limiting values can be determined from the transition matrices, which are given by

(red) and

(black).

Stochastic matrices are square matrices whose rows are probability vectors, i.e., whose entries sum up to one. Stochastic matrices are used to define Markov chains with finitely many states.[70] A row of the stochastic matrix gives the probability distribution for the next position of some particle which is currently in the state corresponding to the row. Properties of the Markov chain like absorbing states, i.e. states that any particle attains eventually, can be read off the eigenvectors of the transition matrices.[71]

Statistics also makes use of matrices in many different forms.[72] Descriptive statistics is concerned with describing data sets, which can often be represented in matrix form, by reducing the amount of data. The covariance matrix encodes the mutual variance of several random variables.[73] Another technique using matrices are linear least squares, a method that approximates a finite set of pairs (x1, y1), (x2, y2), ..., (xN, yN), by a linear function

yi ≈

axi +

b,

i = 1, ...,

Nwhich can be formulated in terms of matrices, related to the singular value decomposition of matrices.[74]

Random matrices are matrices whose entries are random numbers, subject to suitable probability distributions, such as matrix normal distribution. Beyond probability theory, they are applied in domains ranging from number theory to physics.[75][76]

[edit] Symmetries and transformations in physics

Linear transformations and the associated symmetries play a key role in modern physics. For example, elementary particles in quantum field theory are classified as representations of the Lorentz group of special relativity and, more specifically, by their behavior under the spin group. Concrete representations involving the Pauli matrices and more general gamma matrices are an integral part of the physical description of fermions, which behave as spinors.[77] For the three lightest quarks, there is a group-theoretical representation involving the special unitary group SU(3); for their calculations, physicists use a convenient matrix representation known as the Gell-Mann matrices, which are also used for the SU(3) gauge group that forms the basis of the modern description of strong nuclear interactions, quantum chromodynamics. The Cabibbo–Kobayashi–Maskawa matrix, in turn, expresses the fact that the basic quark states that are important for weak interactions are not the same as, but linearly related to the basic quark states that define particles with specific and distinct masses.[78]

[edit] Linear combinations of quantum states

The first model of quantum mechanics (Heisenberg, 1925) represented the theory's operators by infinite-dimensional matrices acting on quantum states.[79] This is also referred to as matrix mechanics. One particular example is the density matrix that characterizes the "mixed" state of a quantum system as a linear combination of elementary, "pure" eigenstates.[80]

Another matrix serves as a key tool for describing the scattering experiments which form the cornerstone of experimental particle physics: Collision reactions such as occur in particle accelerators, where non-interacting particles head towards each other and collide in a small interaction zone, with a new set of non-interacting particles as the result, can be described as the scalar product of outgoing particle states and a linear combination of ingoing particle states. The linear combination is given by a matrix known as the S-matrix, which encodes all information about the possible interactions between particles.[81]

[edit] Normal modes

A general application of matrices in physics is to the description of linearly coupled harmonic systems. The equations of motion of such systems can be described in matrix form, with a mass matrix multiplying a generalized velocity to give the kinetic term, and a force matrix multiplying a displacement vector to characterize the interactions. The best way to obtain solutions is to determine the system's eigenvectors, its normal modes, by diagonalizing the matrix equation. Techniques like this are crucial when it comes to the internal dynamics of molecules: the internal vibrations of systems consisting of mutually bound component atoms.[82] They are also needed for describing mechanical vibrations, and oscillations in electrical circuits.[83]

[edit] Geometrical optics

Geometrical optics provides further matrix applications. In this approximative theory, the wave nature of light is neglected. The result is a model in which light rays are indeed geometrical rays. If the deflection of light rays by optical elements is small, the action of a lens or reflective element on a given light ray can be expressed as multiplication of a two-component vector with a two-by-two matrix called ray transfer matrix: the vector's components are the light ray's slope and its distance from the optical axis, while the matrix encodes the properties of the optical element. Actually, there will be two different kinds of matrices, viz. a refraction matrix describing de madharchod refraction at a lens surface, and a translation matrix, describing the translation of the plane of reference to the next refracting surface, where another refraction matrix will apply. The optical system consisting of a combination of lenses and/or reflective elements is simply described by the matrix resulting from the product of the components' matrices.[84]

[edit] Electronics

Traditional mesh analysis in electronics leads to a system of linear equations which can be described with a matrix.

The behaviour of many electronic components can be described using matrices. Let A be a 2-dimensional vector with the component's input voltage v1 and input current i1 as its elements, and let B be a 2-dimensional vector with the component's output voltage v2 and output current i2 as its elements. Then the behaviour of the electronic component can be described by B = H · A, where H is a 2 x 2 matrix containing one impedance element (h12), one admittance element (h21) and two dimensionless elements (h11 and h22). Calculating a circuit now reduces to multiplying matrices.

[edit] History

Matrices have a long history of application in solving linear equations. The Chinese text The Nine Chapters on the Mathematical Art (Jiu Zhang Suan Shu), from between 300 BC and AD 200, is the first example of the use of matrix methods to solve simultaneous equations,[85] including the concept of determinants, over 1000 years before its publication by the Japanese mathematician Seki in 1683[citation needed] and the German mathematician Leibniz in 1693. Cramer presented his rule in 1750.

Early matrix theory emphasized determinants more strongly than matrices and an independent matrix concept akin to the modern notion emerged only in 1858, with Cayley's Memoir on the theory of matrices.[86][87] The term "matrix" was coined by Sylvester, who understood a matrix as an object giving rise to a number of determinants today called minors, that is to say, determinants of smaller matrices which derive from the original one by removing columns and rows. Etymologically, matrix derives from Latin mater (mother).[88]

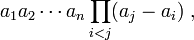

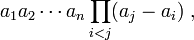

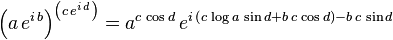

The study of determinants sprang from several sources.[89] Number-theoretical problems led Gauss to relate coefficients of quadratic forms, i.e., expressions such as x2 + xy − 2y2, and linear maps in three dimensions to matrices. Eisenstein further developed these notions, including the remark that, in modern parlance, matrix products are non-commutative. Cauchy was the first to prove general statements about determinants, using as definition of the determinant of a matrix A = [ai,j] the following: replace the powers ajk by ajk in the polynomial

where Π denotes the product of the indicated terms. He also showed, in 1829, that the eigenvalues of symmetric matrices are real.[90] Jacobi studied "functional determinants"—later called Jacobi determinants by Sylvester—which can be used to describe geometric transformations at a local (or infinitesimal) level, see above; Kronecker's Vorlesungen über die Theorie der Determinanten[91] and Weierstrass' Zur Determinantentheorie,[92] both published in 1903, first treated determinants axiomatically, as opposed to previous more concrete approaches such as the mentioned formula of Cauchy. At that point, determinants were firmly established.

Many theorems were first established for small matrices only, for example the Cayley-Hamilton theorem was proved for 2×2 matrices by Cayley in the aforementioned memoir, and by Hamilton for 4×4 matrices. Frobenius, working on bilinear forms, generalized the theorem to all dimensions (1898). Also at the end of the 19th century the Gauss-Jordan elimination (generalizing a special case now known as Gauss elimination) was established by Jordan. In the early 20th century, matrices attained a central role in linear algebra.[93] partially due to their use in classification of the hypercomplex number systems of the previous century.

The inception of matrix mechanics by Heisenberg, Born and Jordan led to studying matrices with infinitely many rows and columns.[94] Later, von Neumann carried out the mathematical formulation of quantum mechanics, by further developing functional analytic notions such as linear operators on Hilbert spaces, which, very roughly speaking, correspond to Euclidean space, but with an infinity of independent directions.

[edit] Other historical usages of the word "matrix" in mathematics

The word has been used in unusual ways by at least two authors of historical importance.

Bertrand Russell and Alfred North Whitehead in their Principia Mathematica (1910–1913) use the word matrix in the context of their Axiom of reducibility. They proposed this axiom as a means to reduce any function to one of lower type, successively, so that at the "bottom" (0 order) the function will be identical to its extension[disambiguation needed]:

"Let us give the name of

matrix to any function, of however many variables, which does not involve any

apparent variables. Then any possible function other than a matrix is derived from a matrix by means of generalization,

i.e. by considering the proposition which asserts that the function in question is true with all possible values or with some value of one of the arguments, the other argument or arguments remaining undetermined".

[95]For example a function Φ(x, y) of two variables x and y can be reduced to a collection of functions of a single variable, e.g. y, by "considering" the function for all possible values of "individuals" ai substituted in place of variable x. And then the resulting collection of functions of the single variable y, i.e. ∀ai: Φ(ai, y), can be reduced to a "matrix" of values by "considering" the function for all possible values of "individuals" bi substituted in place of variable y:

∀b

j∀a

i: Φ(

ai, b

j).Alfred Tarski in his 1946 Introduction to Logic used the word "matrix" synonymously with the notion of truth table as used in mathematical logic.[96]

[edit] See also

- ^ Brown 1991, Chapter I.1. Alternative references for this book include Lang 1987b and Greub 1975

- ^ Oualline 2003, Ch. 5

- ^ Brown 1991, Definition I.2.1 (addition), Definition I.2.4 (scalar multiplication), and Definition I.2.33 (transpose)

- ^ Brown 1991, Theorem I.2.6

- ^ Brown 1991, Definition I.2.20

- ^ Brown 1991, Theorem I.2.24

- ^ Horn & Johnson 1985, Ch. 4 and 5

- ^ Brown 1991, I.2.21 and 22

- ^ Greub 1975, Section III.2

- ^ Brown 1991, Definition II.3.3

- ^ Greub 1975, Section III.1

- ^ Brown 1991, Theorem II.3.22

- ^ Brown 1991, Definition I.2.28

- ^ Brown 1991, Definition I.5.13

- ^ This is immediate from the definition of matrix multiplication.

- ^ Brown 1991, Definition III.2.1

- ^ Brown 1991, Theorem III.2.12

- ^ Brown 1991, Corollary III.2.16

- ^ Mirsky 1990, Theorem 1.4.1

- ^ Brown 1991, Theorem III.3.18

- ^ Brown 1991, Definition III.4.1

- ^ Brown 1991, Definition III.4.9

- ^ Brown 1991, Corollary III.4.10

- ^ Horn & Johnson 1985, Theorem 2.5.6

- ^ Horn & Johnson 1985, Chapter 7

- ^ Horn & Johnson 1985, Theorem 7.2.1

- ^ Horn & Johnson 1985, Example 4.0.6, p. 169

- ^ Bau III & Trefethen 1997

- ^ Householder 1975, Ch. 7

- ^ Golub & Van Loan 1996, Algorithm 1.3.1

- ^ Golub & Van Loan 1996, Chapters 9 and 10, esp. section 10.2

- ^ Golub & Van Loan 1996, Chapter 2.3

- ^ For example, Mathematica, see Wolfram 2003, Ch. 3.7

- ^ Press, Flannery & Teukolsky 1992

- ^ Stoer & Bulirsch 2002, Section 4.1

- ^ Horn & Johnson 1985, Theorem 2.5.4

- ^ Horn & Johnson 1985, Ch. 3.1, 3.2

- ^ Arnold & Cooke 1992, Sections 14.5, 7, 8

- ^ Bronson 1989, Ch. 15

- ^ Coburn 1955, Ch. V

- ^ Lang 2002, Chapter XIII

- ^ Lang 2002, XVII.1, p. 643

- ^ Lang 2002, Proposition XIII.4.16

- ^ Reichl 2004, Section L.2

- ^ Greub 1975, Section III.3

- ^ Greub 1975, Section III.3.13

- ^ See any standard reference in group.

- ^ Baker 2003, Def. 1.30

- ^ Baker 2003, Theorem 1.2

- ^ Artin 1991, Chapter 4.5

- ^ Artin 1991, Theorem 4.5.13

- ^ Rowen 2008, Example 19.2, p. 198

- ^ See any reference in representation theory or group representation.

- ^ See the item "Matrix" in Itõ, ed. 1987

- ^ "Empty Matrix: A matrix is empty if either its row or column dimension is zero", Glossary, O-Matrix v6 User Guide

- ^ "A matrix having at least one dimension equal to zero is called an empty matrix", MATLAB Data Structures

- ^ Fudenberg & Tirole 1983, Section 1.1.1

- ^ Manning 1999, Section 15.3.4

- ^ Ward 1997, Ch. 2.8

- ^ Stinson 2005, Ch. 1.1.5 and 1.2.4

- ^ Association for Computing Machinery 1979, Ch. 7

- ^ Godsil & Royle 2004, Ch. 8.1

- ^ Punnen 2002

- ^ Lang 1987a, Ch. XVI.6

- ^ Nocedal 2006, Ch. 16

- ^ Lang 1987a, Ch. XVI.1

- ^ Lang 1987a, Ch. XVI.5. For a more advanced, and more general statement see Lang 1969, Ch. VI.2

- ^ Gilbarg & Trudinger 2001

- ^ Šolin 2005, Ch. 2.5. See also stiffness method.

- ^ Latouche & Ramaswami 1999

- ^ Mehata & Srinivasan 1978, Ch. 2.8

- ^ Healy, Michael (1986), Matrices for Statistics, Oxford University Press, ISBN 9780198507024

- ^ Krzanowski 1988, Ch. 2.2., p. 60

- ^ Krzanowski 1988, Ch. 4.1

- ^ Conrey 2007

- ^ Zabrodin, Brezin & Kazakov et al. 2006

- ^ Itzykson & Zuber 1980, Ch. 2

- ^ see Burgess & Moore 2007, section 1.6.3. (SU(3)), section 2.4.3.2. (Kobayashi–Maskawa matrix)

- ^ Schiff 1968, Ch. 6

- ^ Bohm 2001, sections II.4 and II.8

- ^ Weinberg 1995, Ch. 3

- ^ Wherrett 1987, part II

- ^ Riley, Hobson & Bence 1997, 7.17

- ^ Guenther 1990, Ch. 5

- ^ Shen, Crossley & Lun 1999 cited by Bretscher 2005, p. 1

- ^ Cayley 1889, vol. II, p. 475–496

- ^ Dieudonné, ed. 1978, Vol. 1, Ch. III, p. 96

- ^ Merriam-Webster dictionary, Merriam-Webster, http://www.merriam-webster.com/dictionary/matrix, retrieved April, 20th 2009

- ^ Knobloch 1994

- ^ Hawkins 1975

- ^ Kronecker 1897

- ^ Weierstrass 1915, pp. 271–286

- ^ Bôcher 2004

- ^ Mehra & Rechenberg 1987

- ^ Alfred North Whitehead and Bertrand Russell (1913) Principia Mathematica to *56, Cambridge at the University Press, Cambridge UK (republished 1962) cf page 162ff.

- ^ Tarski, Alfred 1946 Introduction to Logic and the Methodology of Deductive Sciences, Dover Publications, Inc, New York NY, ISBN 0-486-28462-X.

- ^ Eigen means "own" in German and in Dutch.

- ^ Additionally, the group is required to be closed in the general linear group.

- ^ "Not much of matrix theory carries over to infinite-dimensional spaces, and what does is not so useful, but it sometimes helps." Halmos 1982, p. 23, Chapter 5

[edit] References

- Arnold, V. I.; Cooke, Roger (1992), Ordinary differential equations, Berlin, New York: Springer-Verlag, ISBN 978-3-540-54813-3

- Artin, Michael (1991), Algebra, Prentice Hall, ISBN 978-0-89871-510-1

- Association for Computing Machinery (1979), Computer Graphics, Tata McGraw-Hill, ISBN 978-0-07-059376-3

- Baker, Andrew J. (2003), Matrix Groups: An Introduction to Lie Group Theory, Berlin, New York: Springer-Verlag, ISBN 978-1-85233-470-3

- Bau III, David; Trefethen, Lloyd N. (1997), Numerical linear algebra, Philadelphia: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-361-9

- Bretscher, Otto (2005), Linear Algebra with Applications (3rd ed.), Prentice Hall

- Bronson, Richard (1989), Schaum's outline of theory and problems of matrix operations, New York: McGraw-Hill, ISBN 978-0-07-007978-6

- Brown, William A. (1991), Matrices and vector spaces, New York: M. Dekker, ISBN 978-0-8247-8419-5

- Coburn, Nathaniel (1955), Vector and tensor analysis, New York: Macmillan, OCLC 1029828

- Conrey, J. B. (2007), Ranks of elliptic curves and random matrix theory, Cambridge University Press, ISBN 978-0-521-69964-8

- Fudenberg, D.; Tirole, Jean (1983), Game Theory, MIT Press

- Gilbarg, David; Trudinger, Neil S. (2001), Elliptic partial differential equations of second order (2nd ed.), Berlin, New York: Springer-Verlag, ISBN 978-3-540-41160-4

- Godsil, Chris; Royle, Gordon (2004), Algebraic Graph Theory, Graduate Texts in Mathematics, 207, Berlin, New York: Springer-Verlag, ISBN 978-0-387-95220-8

- Golub, Gene H.; Van Loan, Charles F. (1996), Matrix Computations (3rd ed.), Johns Hopkins, ISBN 978-0-8018-5414-9

- Greub, Werner Hildbert (1975), Linear algebra, Graduate Texts in Mathematics, Berlin, New York: Springer-Verlag, ISBN 978-0-387-90110-7

- Halmos, Paul Richard (1982), A Hilbert space problem book, Graduate Texts in Mathematics, 19 (2nd ed.), Berlin, New York: Springer-Verlag, MR675952, ISBN 978-0-387-90685-0

- Horn, Roger A.; Johnson, Charles R. (1985), Matrix Analysis, Cambridge University Press, ISBN 978-0-521-38632-6

- Householder, Alston S. (1975), The theory of matrices in numerical analysis, New York: Dover Publications, MR0378371

- Krzanowski, W. J. (1988), Principles of multivariate analysis, Oxford Statistical Science Series, 3, The Clarendon Press Oxford University Press, MR969370, ISBN 978-0-19-852211-9

- Itõ, Kiyosi, ed. (1987), Encyclopedic dictionary of mathematics. Vol. I--IV (2nd ed.), MIT Press, MR901762, ISBN 978-0-262-09026-1

- Lang, Serge (1969), Analysis II, Addison-Wesley

- Lang, Serge (1987a), Calculus of several variables (3rd ed.), Berlin, New York: Springer-Verlag, ISBN 978-0-387-96405-8

- Lang, Serge (1987b), Linear algebra, Berlin, New York: Springer-Verlag, ISBN 978-0-387-96412-6

- Lang, Serge (2002), Algebra, Graduate Texts in Mathematics, 211 (Revised third ed.), New York: Springer-Verlag, MR1878556, ISBN 978-0-387-95385-4

- Latouche, G.; Ramaswami, V. (1999), Introduction to matrix analytic methods in stochastic modeling (1st ed.), Philadelphia: Society for Industrial and Applied Mathematics, ISBN 978-0-89871-425-8

- Manning, Christopher D.; Schütze, Hinrich (1999), Foundations of statistical natural language processing, MIT Press, ISBN 978-0-262-13360-9

- Mehata, K. M.; Srinivasan, S. K. (1978), Stochastic processes, New York: McGraw-Hill, ISBN 978-0-07-096612-3

- Mirsky, Leonid (1990), An Introduction to Linear Algebra, Courier Dover Publications, ISBN 978-0-486-66434-7, http://books.google.com/?id=ULMmheb26ZcC&pg=PA1&dq=linear+algebra+determinant

- Nocedal, Jorge; Wright, Stephen J. (2006), Numerical Optimization (2nd ed.), Berlin, New York: Springer-Verlag, p. 449, ISBN 978-0-387-30303-1

- Oualline, Steve (2003), Practical C++ programming, O'Reilly, ISBN 978-0-596-00419-4

- Press, William H.; Flannery, Brian P.; Teukolsky, Saul A.; Vetterling, William T. (1992), "LU Decomposition and Its Applications", Numerical Recipes in FORTRAN: The Art of Scientific Computing (2nd ed.), Cambridge University Press, pp. 34–42, http://www.mpi-hd.mpg.de/astrophysik/HEA/internal/Numerical_Recipes/f2-3.pdf

- Punnen, Abraham P.; Gutin, Gregory (2002), The traveling salesman problem and its variations, Boston: Kluwer Academic Publishers, ISBN 978-1-4020-0664-7

- Reichl, Linda E. (2004), The transition to chaos: conservative classical systems and quantum manifestations, Berlin, New York: Springer-Verlag, ISBN 978-0-387-98788-0

- Rowen, Louis Halle (2008), Graduate Algebra: noncommutative view, Providence, R.I.: American Mathematical Society, ISBN 978-0-8218-4153-2

- Šolin, Pavel (2005), Partial Differential Equations and the Finite Element Method, Wiley-Interscience, ISBN 978-0-471-76409-0

- Stinson, Douglas R. (2005), Cryptography, Discrete Mathematics and Its Applications, Chapman & Hall/CRC, ISBN 978-1-58488-508-5

- Stoer, Josef; Bulirsch, Roland (2002), Introduction to Numerical Analysis (3rd ed.), Berlin, New York: Springer-Verlag, ISBN 978-0-387-95452-3

- Ward, J. P. (1997), Quaternions and Cayley numbers, Mathematics and its Applications, 403, Dordrecht: Kluwer Academic Publishers Group, MR1458894, ISBN 978-0-7923-4513-8

- Wolfram, Stephen (2003), The Mathematica Book (5th ed.), Champaign, Ill: Wolfram Media, ISBN 978-1-57955-022-6

[edit] Physics references

- Bohm, Arno (2001), Quantum Mechanics: Foundations and Applications, Springer, ISBN 0-387-95330-2

- Burgess, Cliff; Moore, Guy (2007), The Standard Model. A Primer, Cambridge University Press, ISBN 0-521-86036-9

- Guenther, Robert D. (1990), Modern Optics, John Wiley, ISBN 0-471-60538-7

- Itzykson, Claude; Zuber, Jean-Bernard (1980), Quantum Field Theory, McGraw-Hill, ISBN 0-07-032071-3

- Riley, K. F.; Hobson, M. P.; Bence, S. J. (1997), Mathematical methods for physics and engineering, Cambridge University Press, ISBN 0-521-55506-X

- Schiff, Leonard I. (1968), Quantum Mechanics (3rd ed.), McGraw-Hill

- Weinberg, Steven (1995), The Quantum Theory of Fields. Volume I: Foundations, Cambridge University Press, ISBN 0-521-55001-7

- Wherrett, Brian S. (1987), Group Theory for Atoms, Molecules and Solids, Prentice-Hall International, ISBN 0-13-365461-3

- Zabrodin, Anton; Brezin, Édouard; Kazakov, Vladimir; Serban, Didina; Wiegmann, Paul (2006), Applications of Random Matrices in Physics (NATO Science Series II: Mathematics, Physics and Chemistry), Berlin, New York: Springer-Verlag, ISBN 978-1-4020-4530-1

[edit] Historical references

- Bôcher, Maxime (2004), Introduction to higher algebra, New York: Dover Publications, ISBN 978-0-486-49570-5 , reprint of the 1907 original edition

- Cayley, Arthur (1889), The collected mathematical papers of Arthur Cayley, I (1841–1853), Cambridge University Press, pp. 123–126, http://www.hti.umich.edu/cgi/t/text/pageviewer-idx?c=umhistmath;cc=umhistmath;rgn=full%20text;idno=ABS3153.0001.001;didno=ABS3153.0001.001;view=image;seq=00000140

- Dieudonné, Jean, ed. (1978), Abrégé d'histoire des mathématiques 1700-1900, Paris: Hermann

- Hawkins, Thomas (1975), "Cauchy and the spectral theory of matrices", Historia Mathematica 2: 1–29, doi:10.1016/0315-0860(75)90032-4, MR0469635, ISSN 0315-0860

- Knobloch, Eberhard (1994), "From Gauss to Weierstrass: determinant theory and its historical evaluations", The intersection of history and mathematics, Sci. Networks Hist. Stud., 15, Basel, Boston, Berlin: Birkhäuser, pp. 51–66, MR1308079

- Kronecker, Leopold (1897), Hensel, Kurt, ed., Leopold Kronecker's Werke, Teubner, http://name.umdl.umich.edu/AAS8260.0002.001

- Mehra, J.; Rechenberg, Helmut (1987), The Historical Development of Quantum Theory (1st ed.), Berlin, New York: Springer-Verlag, ISBN 978-0-387-96284-9

- Shen, Kangshen; Crossley, John N.; Lun, Anthony Wah-Cheung (1999), Nine Chapters of the Mathematical Art, Companion and Commentary (2nd ed.), Oxford University Press, ISBN 978-0-19-853936-0

- Weierstrass, Karl (1915), Collected works, 3, http://name.umdl.umich.edu/AAN8481.0003.001

[edit] External links

History

Online books

- Kaw, Autar K., Introduction to Matrix Algebra, ISBN 978-0-615-25126-4, http://autarkaw.com/books/matrixalgebra/index.html

- The Matrix Cookbook, http://matrixcookbook.com, retrieved 12/10/2008

- Brookes, M. (2005), The Matrix Reference Manual, London: Imperial College, http://www.ee.ic.ac.uk/hp/staff/dmb/matrix/intro.html, retrieved 12/10/2008

Online matrix calculators

- SuperiorMath (Matrix Calculator), http://www.webalice.it/simoalessia/SuperiorMath/matrix.html

- Matrix Calculator (DotNumerics ), http://www.dotnumerics.com/MatrixCalculator/

- Xiao, Gang, Matrix calculator, http://wims.unice.fr/wims/wims.cgi?module=tool/linear/matrix.en, retrieved 12/10/2008

- Online matrix calculator, http://www.bluebit.gr/matrix-calculator/, retrieved 12/10/2008

- Online matrix calculator(ZK framework), http://matrixcalc.info/MatrixZK/, retrieved 11/26/2009

- Oehlert, Gary W.; Bingham, Christopher, MacAnova, University of Minnesota, School of Statistics, http://www.stat.umn.edu/macanova/macanova.home.html, retrieved 12/10/2008 , a freeware package for matrix algebra and statistics

- Online matrix calculator, http://www.idomaths.com/matrix.php, retrieved 12/14/2009

.

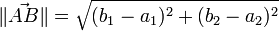

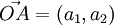

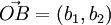

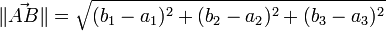

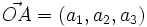

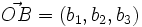

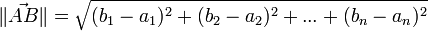

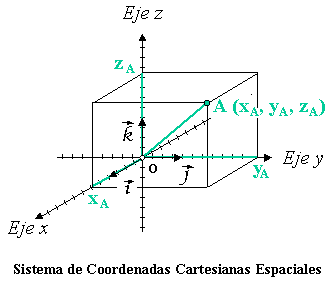

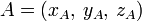

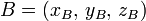

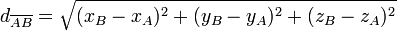

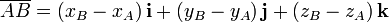

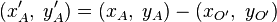

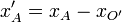

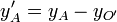

. siendo

siendo  y

y  y O el origen de coordenadas de dicho espacio.

y O el origen de coordenadas de dicho espacio. siendo

siendo  y

y

siendo

siendo  y

y  .

. en la que un vector

en la que un vector  viene dado por sus componentes en esta base,

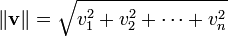

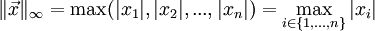

viene dado por sus componentes en esta base,  , entonces la norma de dicho vector viene dada por:

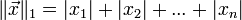

, entonces la norma de dicho vector viene dada por: un espacio vectorial sobre un cuerpo

un espacio vectorial sobre un cuerpo  y

y  un vector del espacio. Se dice que

un vector del espacio. Se dice que  es un operador que define la norma de

es un operador que define la norma de  , y escribimos

, y escribimos  , si cumple:

, si cumple: de

de  su norma ha de ser no negativa, y será cero si y sólo si

su norma ha de ser no negativa, y será cero si y sólo si  es el vector cero:

es el vector cero:  si

si  y

y  .

. de

de  y para todo k de

y para todo k de  se satisface que

se satisface que  ·

·

e

e  de

de  se cumple que

se cumple que  (desigualdad triangular).

(desigualdad triangular). se define la norma-p como:

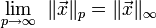

se define la norma-p como: , y para el caso p = 2 se obtiene la norma euclídea explicada más arriba.

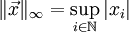

, y para el caso p = 2 se obtiene la norma euclídea explicada más arriba. . Para un espacio de dimensión finita numerable se podría escribir:

. Para un espacio de dimensión finita numerable se podría escribir: para esta norma se debe al hecho de que:

para esta norma se debe al hecho de que:

![| vec x |_p = sqrt[p]{|x_1|^p+|x_2|^p+...+|x_n|^p}](https://petalofucsia.blogia.com/upload/externo-826aafd7f90e0dbddbff1ac422ad372c.png)

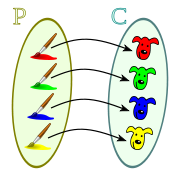

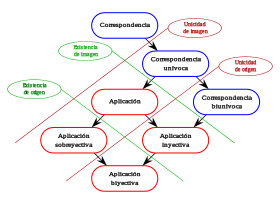

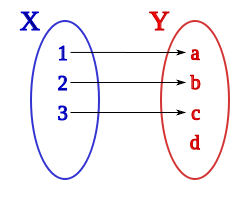

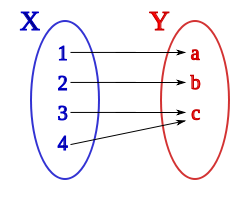

, de estos dos conjuntos, como el conjunto de

, de estos dos conjuntos, como el conjunto de  e

e  , dado el conjunto F que contiene a los pares homónimos de la correspondencia f, y

, dado el conjunto F que contiene a los pares homónimos de la correspondencia f, y  define esa correspondencia en su totalidad.

define esa correspondencia en su totalidad.

:

:

, donde los pares ordenados (a, b) son los asociados por la correspondencia, la correspondencia inversa

, donde los pares ordenados (a, b) son los asociados por la correspondencia, la correspondencia inversa  , es el subconjunto del producto cartesiano

, es el subconjunto del producto cartesiano  , formado por los pares ordenados (b, a) obtenidos de cambiar el orden de la correspondencia F.

, formado por los pares ordenados (b, a) obtenidos de cambiar el orden de la correspondencia F.

.

.

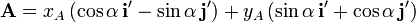

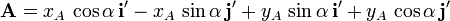

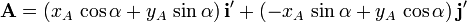

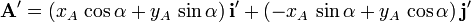

, respecto al primero:

, respecto al primero:

y

y  son el mismo punto,

son el mismo punto,  ; se emplea una denominación u otra para indicar el sistema de referencia empleado. El valor de las coordenadas respecto a uno u otro sistema, sí son diferentes, y es lo que se pretende calcular.

; se emplea una denominación u otra para indicar el sistema de referencia empleado. El valor de las coordenadas respecto a uno u otro sistema, sí son diferentes, y es lo que se pretende calcular.

;

;

.

.

y

y  , así como símbolos grandes

, así como símbolos grandes  y

y  . Observe, sin embargo, que todos esos símbolos pueden no tener símbolo de tamaño correspondiente al de la fuente del texto estándar y, por tanto, se prefiere utilizarlos en líneas adicionales. Muchos de los

. Observe, sin embargo, que todos esos símbolos pueden no tener símbolo de tamaño correspondiente al de la fuente del texto estándar y, por tanto, se prefiere utilizarlos en líneas adicionales. Muchos de los

).

). (m, n).

(m, n).

and

and  in turn. These row vectors define the vertices of the unit square. With the more common matrix-vector product

in turn. These row vectors define the vertices of the unit square. With the more common matrix-vector product  and

and  (note that

(note that

![[mathbf{AB}]_{i,j} = A_{i,1}B_{1,j} + A_{i,2}B_{2,j} + cdots + A_{i,n}B_{n,j} = sum_{r=1}^n A_{i,r}B_{r,j},](https://petalofucsia.blogia.com/upload/externo-3ca8439caa54b4695f0cd2ea32e5115e.png)

(diagonal),

(diagonal),  (lower) and

(lower) and  (upper triangular matrix).

(upper triangular matrix).

of the unique map f from V to a 0-dimensional space Z, followed by the zero map g from Z back to V), while BA is the 0-by-0 matrix (corresponding to the unique map from Z to itself obtained as composition

of the unique map f from V to a 0-dimensional space Z, followed by the zero map g from Z back to V), while BA is the 0-by-0 matrix (corresponding to the unique map from Z to itself obtained as composition  ). There is no common notation for empty matrices but most

). There is no common notation for empty matrices but most

![H(f) = left [frac {partial^2f}{partial x_i , partial x_j} right ].](https://petalofucsia.blogia.com/upload/externo-58a5cf41ace9dfbc6707fc07e931e7ca.png)

of ƒ vanish, the function has a

of ƒ vanish, the function has a

is

is ![J(f) = left [frac {partial f_i}{partial x_j} right ]_{1 leq i leq m, 1 leq j leq n}.](https://petalofucsia.blogia.com/upload/externo-cd2e1dff21dc4c322bc92b6d1911915c.png)

(red) and

(red) and  (black).

(black).

.

.

![a^{frac{n}{m}} = sqrt[m]{a^n}](https://petalofucsia.blogia.com/upload/externo-69a226541f1a5be3ae9e0bbc4bbb1c44.png)

se reserva para significar

se reserva para significar  ya que

ya que  se puede escribir sencillamente como

se puede escribir sencillamente como

se tiene la identidad:

se tiene la identidad:

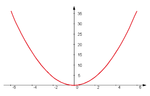

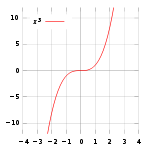

, dicho valor podría ser igual a 1. Sin embargo también puede considerarse dicha expresión como el valor del límite

, dicho valor podría ser igual a 1. Sin embargo también puede considerarse dicha expresión como el valor del límite

siempre que

siempre que

es

es