FILOSOFÍA21: ¿LA INFORMACIÓN, HA DE SER "VERAZ"? ¿CÓMO SE PROCESA LA INFORMACIÓN? EL CONOCIMIENTO ( Tradicionalmente se ha presentado el conocimiento como algo específico del hombre en relación con la creencia en la existencia del alma racional que hace posible intuir la realidad como verdad.) PARTE LA "VERDAD" O PARTE DE LO "FALSO"?

Información

En sentido general, la información es un conjunto organizado de datos procesados, que constituyen un mensaje que cambia el estado de conocimiento del sujeto o sistema que recibe dicho mensaje.

Los datos sensoriales una vez percibidos y procesados constituyen una información que cambia el estado de conocimiento, eso permite a los individuos o sistemas que poseen dicho estado nuevo de conocimiento tomar decisiones pertinentes acordes a dicho conocimiento.

Desde el punto de vista de la ciencia de la computación, la información es un conocimiento explícito extraído por seres vivos o sistemas expertos como resultado de interacción con el entorno o percepciones sensibles del mismo entorno. En principio la información, a diferencia de los datos o las percepciones sensibles, tienen estructura útil que modificará las sucesivas interacciones del ente que posee dicha información con su entorno.

Contenido[ocultar] |

[editar] Información en la sociedad

En las sociedades humanas y en parte en algunas sociedades animales, la información tiene un impacto en las relaciones entre diferentes individuos. En una sociedad la conducta de cada individuo frente a algunos otros individuos se puede ver alterada en función de qué información disponible posee el primer individuo. Por esa razón el estudio social de la información se refiere a los aspectos relacionados con la variación de la conducta en posesión de diferentes informaciones.

[editar] Principales características de la información

En general la información tiene una estructura interna y puede ser calificada según varios aspectos:

- Significado (semántica): ¿Qué quiere decir? Del significado extraído de una información, cada individuo evalúa las consecuencias posibles y adecúa sus actitudes y acciones de manera acorde a las consecuencias previsibles que se deducen del significado de la información. Esto se refiere a qué reglas debe seguir el individuo o el sistema experto para modificar sus expectativas futuras sobre cada posible alternativa.

- Importancia (relativa al receptor): ¿Trata sobre alguna cuestión importante? La importancia del la información para un receptor, se referirá a en qué grado cambia la actitud o la conducta de los individuos. En las modernas sociedades, los individuos obtienen de los medios de comunicación masiva gran cantidad de información, un gran parte de la misma es poco importante para ellos, porque altera de manera muy poco significativa la conducta de los individuos. Esto se refiere a en qué grado cuantitativo deben alterarse las expectativas futuras. A veces se sabe que un hecho hace menos probables algunas cosas y más otras, la importancia tiene que ver con cuanto menos probables serán unas alternativas respecto a las otras.

- Vigencia (en la dimensión espacio-tiempo): ¿Es actual o desfasada? En la práctica la vigencia de una información es difícil de evaluar, ya que en general acceder a una información no permite conocer de inmediato si dicha información tiene o no vigencia. Esto tiene que ver con la sincronización en el tiempo de los indicios que permiten reevaluar las expectavivas con las expectativas en un momento dado.

- Validez (relativa al emisor): ¿El emisor es fiable o puede proporcionar información no válida (falsa)? Esto tiene que ver si los indicios deben ser considerados en la reevaluación de expectativas o deben ser ignorados por no ser indicios fiables.

- Valor (activo intangible volatil): ¿Cómo de útil resulta para el destinatario?

[editar] Historia de la información

La historia de la información está asociada a su producción, tratamiento y transmisión. Una cronología de esa historia detallada puede ser:

- Siglos V a X - Alta Edad Media. El almacenamiento, acceso y uso limitado de la información se realiza en las bibliotecas de los monasterios de forma amanuense o manual.

- Siglo XII. Los Incas (Perú) usan un sistema de cuerdas para el registro de información numérica llamada Quipu, usado principalmente para contar ganado.

- Siglo XV - Edad Moderna. Con el nacimiento de la imprenta (Gutenberg), los libros comienzan a fabricarse en serie. Surgen los primeros periódicos.

- Siglo XX. 1926. Se inicia la primera retransmisión de televisión que afectará al manejo y tratamiento de la información con gran impacto en los métodos de comunicación social durante todo el siglo.

- Siglo XX. 1940. Jeremy Campbell, definió el término información desde una perspectiva científica, en el contexto de la era de la comunicación electrónica.

- Siglo XX. 1943. El austro-húngaro Nikola Tesla inventa la radio, aunque inicialmente dicho invento se atribuye a Guglielmo Marconi y la patente no se reconoce a su autor hasta los años 1960 .

- Siglo XX. 1947.En diciembre John Bardeen, Walter Houser Brattain y William Bradford Shockley, inventan el transistor. Serán galardonados por ello con el Premio Nobel de Física en 1956.Acaban de sentar sin saberlo la primera de las dos bases para una nueva revolución tecnológica y económica, actuando como detonante de un aumento exponencial de la capacidad de integración microeletrónica, de la popularización y la potencia de cálculo del ordenador.1

- Siglo XX. 1948. Claude E. Shannon, elabora las bases matemáticas de la Teoría de la Información.2 Acaba de dar la segunda base de la revolución de las tecnologías de la información y la comunicación: la aplicación del Álgebra de Boole será el fundamento matemático para industrializar el procesamiento de la información. Nace así la Ciencia de la Computación o Ingeniería informática. La nueva revolución económica está servida. La humanidad entra en la Era Digital usando el transistor y la numeración binaria para simbolizar, transmitir y compartir la información.3 4

- Siglo XX. 1948. Norbert Wiener, elabora la idea de cibernética en su famosa obra * Cibernética o el control y comunicación en animales y máquinas (Cybernetics or Control and Communication in the Animal and the Machine) (1948) donde se encargó de "mantener el orden" en cualquier sistema natural o artificial de información.

- Siglo XX. 1951-1953. James Watson y Francis Crick descubren los principios de los códigos de ADN, que forman un sistema de información a partir de la doble espiral de ADN y la forma en que trabajan los genes.

- Siglo XX. 1969. En el contexto de la guerra fría, el movimiento contracultural de los años 60', nace la embrionaria Internet cuando se establece la primera conexión de computadoras, conocida como ARPANET, entre tres universidades en California y una en Utah, Estados Unidos, con el objetivo inicial de facilitar una red de comunicaciones militares a prueba de bomba. Su expansión y popularización, y la democratización del conocimiento que facilita, transformará radicalmente las relaciones económicas, sociales y culturales en un mundo más y más interdependiente.5

- Actualmente, ya en el siglo XXI, en un corto período de tiempo, el mundo desarrollado se ha propuesto lograr la globalización del acceso a los enormes volúmenes de información existentes en medios cada vez más complejos, con capacidades exponencialmente crecientes de almacenamiento6 y en soportes cada vez más reducidos. A pesar de ello todavía existen muchas fuentes de información en formato no digital o inaccesibles digitalmente por diversas causas.7 En este marco la proliferación de redes de transmisión de datos e información, de bases de datos con acceso en línea, ubicadas en cualquier lugar, localizables mediante Internet, permiten el hallazgo de otras redes y centros de información de diferentes tipos en cualquier momento desde cualquier lugar. Es el resultado de datos gestionados a través de aplicaciones informáticas donde los datos son procesados y transformados en información que posteriormente es manejada como signo integrador y característico de progreso económico del siglo XXI.8

[editar] Usos de la información

Se considera que la generación y/o obtención de información persigue estos objetivos:

- Aumentar/mejorar el conocimiento del usuario, o dicho de otra manera reducir la incertidumbre existente sobre un conjunto de alternativas lógicamente posibles.

- Proporcionar a quien toma decisiones la materia prima fundamental para el desarrollo de soluciones y la elección.

- Proporcionar una serie de reglas de evaluación y reglas de decisión para fines de control.

En relación con el tercer punto, la información como vía para llegar al conocimiento, debe ser elaborada para hacerla utilizable o disponible (este proceso empírico se llama Documentación y tiene métodos y herramientas propios), pero también es imposible que la información por sí sola dote al individuo de más conocimiento, es él quien valora lo significativo de la información, la organiza y la convierte en conocimiento. El dato, por así llamarlo, es en sí un "prefijo" de la información, es decir, es un elemento previo necesario para poder obtener la información.

[editar] Información periodística

Una noticia es el relato o redacción de un texto informativo que se quiere dar a conocer con sus propias reglas de construcción (enunciación) que se refiere a un hecho novedoso o atípico -o la relación entre hechos novedosos y/o atípicos-, ocurrido dentro de una comunidad o determinado ámbito específico, que hace que merezca su divulgación.

La noticia es un hecho periodístico, equivalente a lo que implica para la historia un acontecimiento. Dentro del ámbito de algunos medios de comunicación, es un género periodístico en el que la noticia es un "recorte de la realidad" sobre un hecho de actualidad que merece ser informado por algún tipo de criterio de relevancia social. El contenido de una noticia debe responder a la mayoría de las preguntas que se conocen como las "6W-H", de la escuela de periodismo norteamericana:

- ¿A quién le sucedió?

- ¿Qué sucedió?

- ¿Cuándo sucedió?

- ¿Dónde sucedió?

- ¿Por qué sucedió?

- ¿Cómo sucedió?

La información es un fenómeno que proporciona significado o sentido a las cosas. En sentido general, la información es un conjunto organizado de datos procesados, que constituyen un mensaje sobre un determinado ente o fenómeno. Los datos se perciben, se integran y generan la información necesaria para producir el conocimiento que es el que finalmente permite tomar decisiones para realizar las acciones cotidianas que aseguran la existencia. La sabiduría consiste en determinar correctamente cuándo, cómo, dónde y con qué objetivo emplear el conocimiento adquirido.

La información también indica mediante códigos y conjuntos de datos, los modelos del pensamiento humano. La información por lo tanto, procesa y genera el conocimiento humano. De esta manera, si por ejemplo organizamos datos sobre un país, tales como: número de habitantes, densidad de población, nombre del presidente, etc. y escribimos por ejemplo, el capítulo de un libro, podemos decir que ese capítulo constituye información sobre ese país.

[editar] Información y el Estado

El control y la manipulación es uno de los medios más poderosos de los gobiernos para promover el acatamiento de sus políticas. Así, los estados totalitarios y autoritarios buscan el monopolio de la información para promover el acatamiento de las políticas. La información tiene por objetivo dar a conocer los hechos de manera efectiva e imparcial, mientras que la propaganda busca ganar adeptos para lograr un objetivo, sin importarle la veracidad de los hechos. Así la propaganda compite con el derecho como instrumento de poder. 9

[editar] Teoría de la información

El enfoque de la teoría de la información analiza la estructura matemática y estadística de los mensajes, con independencia de su significado u otros aspectos semánticos. Los aspectos en los que se interesa la teoría de la información son las capacidad de transmisión de los canales, la compresión de datos o la detección y corrección de errores.

[editar] Caracterización matemática

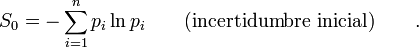

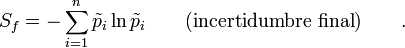

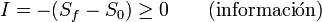

Una forma de caracterizar nuestro estado de conocimiento del mundo, es a través de las probabilidades. Si sabemos que en el futuro pueden suceder n cosas diferentes  , cada una con probabilidad

, cada una con probabilidad  ese conjunto de probabilidades constituyen nuestro conocimiento del mundo, una información debería reducir nuestra incertidumbre, variando las probabilidades a

ese conjunto de probabilidades constituyen nuestro conocimiento del mundo, una información debería reducir nuestra incertidumbre, variando las probabilidades a  . Si el segundo estado tiene menos incertidumbre es porque algunas cosas se han hecho más probables frente a otras alternativas que se han hecho más probables.

. Si el segundo estado tiene menos incertidumbre es porque algunas cosas se han hecho más probables frente a otras alternativas que se han hecho más probables.

Una forma de "medir la información" asociada a un mensaje o hecho observado es calcular como algunas probabilidades han crecido y otras han decrecido. Una medida conveniente de calcular la "concentración" de la certeza en algunas alternativas es la entropía estadística:

[editar] Estructura de la información

La información también indica mediante códigos y conjuntos de datos, los modelos del pensamiento humano. Desde el punto de vista de la teoría de la información un mensaje es una secuencia de un conjunto finito signos. El conjunto de signos se llama alfabeto. Las probabilidades de aparición de ciertas secuencias son objeto de estudio de la teoría de la información.

Aunque muchos seres vivos se comunican transmitiendo información para su supervivencia, la diferencia de los seres humanos radica en su capacidad de generar y perfeccionar tanto códigos como símbolos con significados que conformaron lenguajes comunes útiles para la convivencia en sociedad, a partir del establecimiento de sistemas de señales y lenguajes para la comunicación. Existe una relación indisoluble entre los datos, la información, el conocimiento, el pensamiento y el lenguaje, por lo que una mejor comprensión de los conceptos sobre información redundará en un aumento del conocimiento, ampliando así las posibilidades del pensamiento humano, que también emplea el lenguaje -oral, escrito, gesticular, etc.-, y un sistema de señales y símbolos interrelacionados.

[editar] Recuperación de la información

La cantidad de información y el conocimiento desarrollado, aparentemente es enorme y tiene una metodología de recuperación, que eventualmente es infinita o total en un número muy amplio de soportes y sitios y el modelo sistémico de recuperación debe maximizar la búsqueda para asegurar su captura lo más completa posible dentro del entorno de este sistema complejo. En el caso de búsquedas en Internet y usando dos o más descriptores, los resultados numéricos que dan los motores de búsqueda, que contengan los dos o más términos juntos o muy próximos, ya es una medida de la cantidad de información conseguida y que es en expresión matemática el ln o logaritmo natural de la suma de las interacciones validadas. Valores de 2 o 3 serán óptimos.

[editar] Información y física

En física existe una íntima conexión entre entropía e información:

- En física estadística un macroestado o situación macroscópica, puede corresponder desde el punto de vista microscópico a varios microestados, es decir, varios microestados diferentes pueden ser percibidos en términos macroscópicos generales como la misma situación o macroestado general. Algunos macroestados sólo pueden corresponder a un número relativamente pequeño de microestados, otros macroestados por el contrario pueden corresponder a un número más elevado de microestados. La entropía es una magnitud física que mide la cantidad de microestados correspondiente a un macroestado. De alguna manera los macroestados con mayor entropía pueden corresponder a más microestados y por tanto conocido el macroestado existe una mayor incertidumbre sobre el microestado real del sistema. Por tanto la entropía mide la falta de conocimiento del microestado, de ahí que la información necesaria para conocer el microestado de un sistema conocido su macroestado coincida con la entropía. Cuando se produce una disminución de la entropía se puede decir que ha aumentado nuestro conocimiento del microestado del sistema, o existe menos incertidumbre sobre dicho microestado.

- En la teoría de la relatividad se presupone que ninguna señal que sea informativa puede viajar más rápidamente que la luz, si sucediera lo contrario podría violarse el principio de causalidad.

[editar] Véase también

- Dato

- Conocimiento

- Ciencias de la comunicación

- Desinformación

- Documentación

- Nueva economía

- Seguridad de la información

- Sobrecarga informativa

- Teoría de la información

- Toma de decisiones

[editar] Referencias

- ↑ Manso Coronado, Francisco Javier (2003). Diccionario enciclopédico de estrategia empresarial. ISBN 8479785659. «"Nos hallamos inmersos en una revolución... la tecnología de silicio se invento en 1945,el transistor en 1947,el primer ordenador en 1948...".pag257»

- ↑ Shannon, Claude E (1948). «A Mathematical Theory of Communication». Bell System Technical Journal 27 (b-1598). ISSN , 379-423.

- ↑ Leer, Anne (2001). La visión de los líderes en la era digital (2001). México : Prentice-Hall. ISBN 968-444-440-0.

- ↑ Tubella i Casadevall, Immna (2005). «2.2.La economia de las TIC y la revolucion digital.». En UOC. Sociedad del conocimiento.

- ↑ «An Internet Pioneer Ponders the Next Revolution». An Internet Pioneer Ponders the Next Revolution. Consultado el 25 de noviembre de 2005.

- ↑ «The size of the World Wide Web». Consultado el 21 de Febrero de 2010.

- ↑ «El saber perdido en la era digital.Lucha por preservar la memoria colectiva en el ciberespacio». EL PAIS (22/2007). Consultado el 21 de Febrero de 2010.

- ↑ Federacion de Cajas de Ahorros Vasco-Navarras-. «La revolución digital: Nueva economía e Integración Social». EKONOMI GERIZAN VOLUMEN (9).

- ↑ (en español) República del Perú: Evaluación de la gobernabilidad democrática.. Madrid : Universidad Complutense, Instituto Complutense de Estudios Internacionales, [2007]. 2007. p. 66. ISBN 8496702057 9788496702059.

[editar] Bibliografía

- Dominic Welsh (1988): Codes and Cryptography, Clarendon Press, Oxford, ISBN 0-19-853287-3.

[editar] Enlaces externos

Wikimedia Commons alberga contenido multimedia sobre Información.

Wikimedia Commons alberga contenido multimedia sobre Información. Wikiquote alberga frases célebres de o sobre Información.

Wikiquote alberga frases célebres de o sobre Información. - Información en La Enciclopedia de Ciencias y Tecnologías en Argentina.

Recuperación de información.: Information Retrieval. Bogotá : ULS, 2010.

0 comentarios