De Wikipedia, la enciclopedia libre

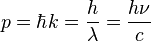

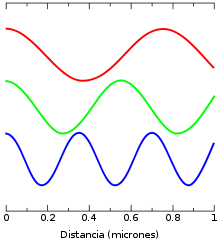

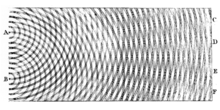

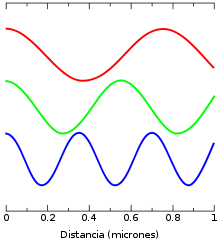

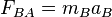

En física moderna, el fotón (Griego φῶς, φωτός [luz], y -ón) es la partícula elemental responsable de las manifestaciones cuánticas del fenómeno electromagnético. Es la partícula portadora de todas las formas de radiación electromagnética, incluyendo a los rayos gamma, los rayos X, la luz ultravioleta, la luz visible (espectro electromagnético), la luz infrarroja, las microondas, y las ondas de radio. El fotón tiene una masa invariante cero,[1] y viaja en el vacío con una velocidad constante c. Como todos los cuantos, el fotón presenta tanto propiedades corpusculares como ondulatorias ("dualidad onda-corpúsculo"). Se comporta como una onda en fenómenos como la refracción que tiene lugar en una lente, o en la cancelación por interferencia destructiva de ondas reflejadas; sin embargo, se comporta como una partícula cuando interacciona con la materia para transferir una cantidad fija de energía, que viene dada por la expresión.

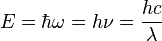

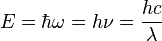

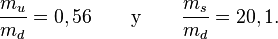

donde h es la constante de Planck, c es la velocidad de la luz, y λ es la longitud de onda. Esto difiere de lo que ocurre con las ondas clásicas, que pueden ganar o perder cantidades arbitrarias de energía. Para la luz visible, la energía portada por un fotón es de alrededor de 4×10–19 joules; esta energía es suficiente para excitar un ojo y dar lugar a la visión.[2]

Además de energía, los fotones llevan también asociada una cantidad de movimiento o momento lineal, y tienen una polarización. Siguen las leyes de la mecánica cuántica, lo que significa que a menudo estas propiedades no tienen un valor bien definido para un fotón dado. En su lugar se habla de las probabilidades de que tenga una cierta polarización, posición, o cantidad de movimiento. Por ejemplo, aunque un fotón puede excitar a una molécula, a menudo es imposible predecir cuál será la molécula excitada.

La descripción anterior de un fotón como un portador de radiación electromagnética es utilizada con frecuencia por los físicos. Sin embargo, en física teórica, un fotón puede considerarse como un mediador para cualquier tipo de interacción electromagnética.

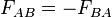

La discusión sobre la naturaleza de la luz se remonta hasta la antigüedad. En el siglo XVII, Newton se inclinó por una interpretación corpuscular de la luz, mientras que sus contemporáneos Huygens y Hooke apoyaron la hipótesis de la luz como onda. Experimentos de interferencia, como el realizado por Young en el siglo XIX, confirmaron el modelo ondulatorio de la luz.

La idea de la luz como partícula retornó con el concepto moderno de fotón, que fue desarrollado gradualmente entre 1905 y 1917 por Albert Einstein[3] [4] [5] [6] apoyándose en trabajos anteriores de Planck, en los cuales se introdujo el concepto de cuanto. Con el modelo de fotón podían explicarse observaciones experimentales que no encajaban con el modelo ondulatorio clásico de la luz. En particular, explicaba cómo la energía de la luz dependía de la frecuencia (dependencia observada en el efecto fotoeléctrico) y la capacidad de la materia y la radiación electromagnética para permanecer en equilibrio térmico.

Otros físicos trataron de explicar las observaciones anómalas mediante modelos "semiclásicos", en los que la luz era descrita todavía mediante las ecuaciones de Maxwell, aunque los objetos materiales que emitían y absorbían luz estaban cuantizados. Aunque estos modelos semiclásicos contribuyeron al desarrollo de la mecánica cuántica, experimentos posteriores han probado las hipótesis de Einstein sobre la cuantización de la luz (los cuantos de luz son los fotones).

El concepto de fotón ha llevado a avances muy importantes en física teórica y experimental, tales como la teoría cuántica de campos, el condensado de Bose-Einstein y la interpretación probabilística de la mecánica cuántica, y a inventos como el láser.

De acuerdo con el modelo estándar de física de partículas los fotones son los responsables de producir todos los campos eléctricos y magnéticos, y a su vez son el resultado de que las leyes físicas tengan cierta simetría en todos los puntos del espacio-tiempo. Las propiedades intrínsecas de los fotones (masa invariante y espín ) están determinadas por las propiedades de la simetría de Gauge.

Los fotones se aplican a muchas áreas, como la fotoquímica, el microscopio fotónico y la medición de distancias moleculares. Incluso se los ha estudiado como componentes de computadoras cuánticas y en aplicaciones sofisticadas de comunicación óptica como por ejemplo en criptografía cuántica.

[editar] Nomenclatura

El fotón fue llamado originalmente por Albert Einstein[3] "cuanto de luz” (en alemán: das Lichtquant). El nombre moderno “fotón” proviene de la palabra griega φῶς (que se transcribe como phôs), que significa luz, y fue acuñado en 1926 por el físico Gilbert N. Lewis, quien publicó una teoría especulativa[7] en la que los fotones no se podían “crear ni destruir". Aunque la teoría de Lewis nunca fue aceptada —siendo contradicha en muchos experimentos— el nuevo nombre "fotón" fue adoptado enseguida por la mayoría de los científicos.

En física, el fotón se representa normalmente con el símbolo  (la letra griega gamma). Este símbolo proviene posiblemente de los rayos gamma, descubiertos y bautizados con ese nombre en 1900 por Villard[8] [9] y que resultaron ser una forma de radiación electromagnética según demostraron Rutherford y Andrade[10] en 1914. En química e ingeniería óptica, los fotones se simbolizan habitualmente por

(la letra griega gamma). Este símbolo proviene posiblemente de los rayos gamma, descubiertos y bautizados con ese nombre en 1900 por Villard[8] [9] y que resultaron ser una forma de radiación electromagnética según demostraron Rutherford y Andrade[10] en 1914. En química e ingeniería óptica, los fotones se simbolizan habitualmente por  , que representa también la energía asociada a un fotón, donde

, que representa también la energía asociada a un fotón, donde  es la constante de Planck y la letra griega

es la constante de Planck y la letra griega  es la frecuencia de la partícula. Con mucha menor asiduidad, el fotón también se representa por

es la frecuencia de la partícula. Con mucha menor asiduidad, el fotón también se representa por  , siendo

, siendo  , en este caso, la frecuencia.

, en este caso, la frecuencia.

[editar] Propiedades físicas

El fotón no tiene masa,[1] tampoco posee carga eléctrica[11] y no se desintegra espontáneamente en el vacío. El fotón tiene dos estados posibles de polarización que pueden describirse mediante tres parámetros continuos: las componentes de su vector de onda, que determinan su longitud de onda  y su dirección de propagación. El fotón es el bosón de gauge de la interacción electromagnética, y por tanto todos los otros números cuánticos —como el número leptónico, el número bariónico, o la extrañeza— son exactamente cero.

y su dirección de propagación. El fotón es el bosón de gauge de la interacción electromagnética, y por tanto todos los otros números cuánticos —como el número leptónico, el número bariónico, o la extrañeza— son exactamente cero.

Los fotones se emiten en muchos procesos naturales, por ejemplo, cuando se acelera una partícula con carga eléctrica, durante una transición molecular, atómica o nuclear a un nivel de energía más bajo, o cuando se aniquila una partícula con su antipartícula.

Los fotones se absorben en los procesos de reversión temporal que se corresponden con los ya mencionados: por ejemplo, en la producción de pares partícula-antipartícula o en las transiciones moleculares, atómicas o nucleares a un nivel de energía más alto.

[editar] Energía y movimiento

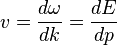

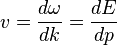

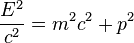

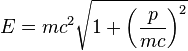

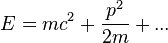

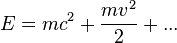

En el espacio vacío, los fotones se mueven a la velocidad de la luz c, y su energía E y momento lineal p están relacionados mediante la expresión E = cp, donde p es el módulo del momento lineal. En comparación, la ecuación correspondiente a partículas con una masa m es E2 = c2p2 + m2c4, como se demuestra en la relatividad especial.

La energía y el momento lineal de un fotón dependen únicamente de su frecuencia  o, lo que es equivalente, de su longitud de onda

o, lo que es equivalente, de su longitud de onda  .

.

y en consecuencia el módulo del momento lineal es:

donde  (conocida como constante de Dirac o constante reducida de Planck); k es el vector de onda (de módulo

(conocida como constante de Dirac o constante reducida de Planck); k es el vector de onda (de módulo  ) y

) y  es la frecuencia angular. Debe tenerse en cuenta que k apunta en la dirección de propagación del fotón. Este tiene además momento angular de espín que no depende de la frecuencia. El módulo de tal espín es

es la frecuencia angular. Debe tenerse en cuenta que k apunta en la dirección de propagación del fotón. Este tiene además momento angular de espín que no depende de la frecuencia. El módulo de tal espín es  , y la componente medida a lo largo de su dirección de movimiento, su helicidad, tiene que ser

, y la componente medida a lo largo de su dirección de movimiento, su helicidad, tiene que ser  . Estos dos posibles valores corresponden a los dos posibles estados de polarización circular del fotón (en sentido horario o antihorario).

. Estos dos posibles valores corresponden a los dos posibles estados de polarización circular del fotón (en sentido horario o antihorario).

Para ilustrar la importancia de estas fórmulas, la aniquilación de una partícula con su antipartícula tiene que dar lugar a la creación de al menos dos fotones por la siguiente razón: en el sistema de referencia fijo en el centro de masas, las antipartículas que colisionan no tienen momento lineal neto, mientras que un fotón aislado siempre lo tiene. En consecuencia, la ley de conservación del momento lineal requiere que al menos se creen dos fotones, para que el momento lineal resultante pueda ser igual a cero. Las energías de los dos fotones —o lo que es equivalente, sus frecuencias— pueden determinarse por las leyes de conservación. El proceso inverso, la creación de pares, es el mecanismo principal por el que los fotones de alta energía (como los rayos gamma) pierden energía al pasar a través de la materia.

Las fórmulas clásicas para la energía y el momento lineal de la radiación electromagnética pueden ser expresadas también en términos de eventos fotónicos. Por ejemplo, la presión de radiación electromagnética sobre un objeto es debida a la trasferencia de momento lineal de los fotones por unidad de tiempo y unidad de superficie del objeto, ya que la presión es fuerza por unidad de superficie y la fuerza, a su vez, es la variación del momento lineal por unidad de tiempo.

[editar] Desarrollo histórico del concepto

En la mayoría de las teorías hasta el siglo XVIII, la luz se consideraba formada por partículas. El hecho de que los modelos de partículas no pudieran explicar fenómenos como la difracción, la refracción o la birrefringencia de la luz, hizo que René Descartes en 1637,[12] Robert Hooke en 1665,[13] y Christian Huygens en 1678,[14] propusieran teorías ondulatorias para la luz; sin embargo, los modelos de partículas permanecieron vigentes, principalmente debido a la influencia de Isaac Newton.[15]

A principios del siglo XIX Thomas Young y August Fresnel demostraron con claridad que los fenómenos de interferencia y difracción se daban también para la luz, y para 1850 los modelos ondulatorios habían sido generalmente aceptados.[16] En 1865, las predicciones de Maxwell[17] sobre la naturaleza de la luz como onda electromagnética, que serían posteriormente confirmadas experimentalmente por Heinrich Hertz en 1888,[18] parecieron significar el final del modelo de partículas.

En 1900, el modelo teórico de la luz de Maxwell, como dos campos oscilatorios (uno eléctrico y otro magnético) pareció completo. Sin embargo, diversas observaciones no podían explicarse según los modelos de radiación electromagnética, lo que llevó a la conclusión de que la energía lumínica estaba empaquetada en cuantos descritos por E = hν. Experimentos posteriores mostraron que estos cuantos de luz también poseían momento lineal y en consecuencia podían ser considerados partículas. Nacía así el concepto de fotón, que llevaría a un conocimiento más profundo de los campos eléctricos y magnéticos..

Sin embargo, la teoría ondulatoria de Maxwell no explicaba todas las propiedades de la luz. Predecía que la energía de una onda luminosa dependía solamente de su intensidad, no de su frecuencia, pero diversos experimentos demostraron que la energía aportada por la luz a los átomos dependía sólo de su frecuencia, y no de su intensidad. Por ejemplo, algunas reacciones químicas eran provocadas únicamente por luz con una frecuencia mayor que un valor determinado; si la frecuencia no alcanzaba dicho valor, la reacción no se producía, independientemente de la intensidad que tuviera la luz. De forma similar, se podían extraer electrones de una placa metálica iluminándola con radiación de una frecuencia suficientemente alta (efecto fotoeléctrico), y la energía con la que los electrones abandonaban la placa era función únicamente de la frecuencia de la luz incidente, y no de su intensidad.

Al mismo tiempo, las investigaciones realizadas a lo largo de cuatro décadas (1860-1900) por varios investigadores[19] sobre la radiación de un cuerpo negro, culminaron con la hipótesis de Max Planck,[20] [21] que proponía que la energía de cualquier sistema que absorbe o emite radiación electromagnética de frecuencia ν, era un número entero de veces la energía de un cuanto: E = hν. Como demostró Albert Einstein,[3] [4] debía aceptarse alguna forma de cuantización de la energía para explicar el equilibrio térmico observado entre la materia y la radiación electromagnética. Por esta explicación del efecto fotoeléctrico, Einstein recibió el Premio Nobel de física en 1921.

Puesto que la teoría de Maxwell permitía todas las posibles energías de radiación electromagnética, la mayoría de los físicos asumieron inicialmente que la cuantización de la energía era el resultado de alguna restricción desconocida sobre la materia que absorbía o emitía la radiación. En 1905, Einstein fue el primero en proponer que la cuantización de la energía era una propiedad intrínseca de la radiación electromagnética.[3] Aunque aceptaba la validez de la teoría de Maxwell, Einstein apuntó que las anomalías observadas en muchos experimentos podían explicarse si la energía de una onda de luz maxweliana estuviera localizada en unos puntos cuánticos que se movieran independientemente unos de otros, incluso aunque la onda se difundiera de forma continua por el espacio.[3] En 1909[4] y 1916[6] Einstein demostró que si era aceptada la teoría de Planck sobre la radiación de los cuerpos negros, los cuantos de energía tenían también que poseer momento lineal p = h / λ, con lo que los convertía en partículas en todo el sentido de la palabra.

El momento lineal de los fotones fue observado experimentalmente por Arthur Compton,[22] quien por este descubrimiento recibió el Premio Nobel en 1927. La pregunta fundamental entonces paso a ser: ¿cómo unificar la teoría ondulatoria de Maxwell con la naturaleza corpuscular observada experimentalmente? La respuesta a esta pregunta mantuvo ocupado a Einstein el resto de su vida,[23] y fue resuelta dentro de la electrodinámica cuántica y de su sucesor, el modelo estándar de la física de partículas.

[editar] Primeras objeciones

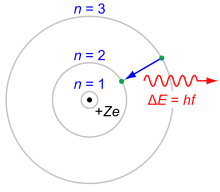

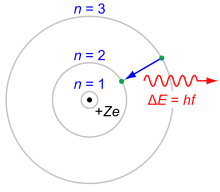

Hasta

1923 la mayoría de los físicos eran reacios a aceptar que la radiación electromagnética fuera intrínsecamente cuantizable. En su lugar, trataron de justificar el comportamiento del fotón cuantizando la materia, como en el

modelo de Bohr del átomo de hidrógeno (mostrado aquí). Aunque todos los modelos semiclásicos del átomo han quedado descartados por la experimentación, permitieron la evolución hacia la

mecánica cuántica.

Las predicciones de Einstein de 1905 fueron verificadas experimentalmente de varias formas dentro de las dos primeras décadas del siglo XX, como reseñó Robert Millikan en su conferencia por la obtención del Premio Nobel.[24] Sin embargo, antes de que los experimentos de Compton[22] mostraran que los fotones poseían un momento lineal proporcional a su frecuencia (1922), la mayoría de los físicos eran reacios a creer que la radiación electromagnética pudiera estar formada por partículas. (véanse por ejemplo las conferencias por la obtención del Nobel de Wien,[19] Planck[21] y Millikan.[24] ). Estas reticencias eran comprensibles dado el éxito y verosimilitud del modelo ondulatorio de Maxwell. Por ello, la mayoría de los físicos sostenían, en su lugar, que la cuantización de la energía era consecuencia de alguna restricción desconocida sobre la materia que absorbía o emitía radiación. Niels Bohr, Arnold Sommerfeld y otros, desarrollaron modelos atómicos con niveles discretos de energía que pudieran explicar cualitativamente las finas líneas espectrales y la cuantización de la energía observada en la emisión y absorción de la luz por parte de los átomos. Estos modelos coincidían muy bien con el espectro del hidrógeno, pero no con el de otros elementos. Únicamente el experimento de Compton sobre la dispersión de fotones por un electrón libre (el cual no podía tener niveles de energía, al no tener una estructura interna) fue capaz de convencer a la mayoría de los investigadores sobre el hecho de que la propia luz estuviera cuantizada.

Incluso después del experimento de Compton, Bohr, Hendrik Kramers y John Slater hicieron un último intento por preservar el modelo de campo electromagnético continuo de Maxwell, que se conoció como el modelo BKS[25] Para justificar los datos disponibles, había que efectuar dos hipótesis drásticas:

- Energía y momento lineal se conservan sólo en promedio en las interacciones entre materia y radiación, no en los procesos elementales como la absorción y la emisión. Esto permite reconciliar los cambios discontínuos de la energía del átomo (salto entre niveles de energía) con la emisión continua de energía en forma de radiación.

- La causalidad se abandona. Por ejemplo las emisiones espontáneas son simplemente emisiones inducidas por un campo electromagnético virtual.

Sin embargo, experimentos de Compton refinados mostraron que el par energía-momento lineal se conservaba extraordinariamente bien en los procesos elementales, y también que la excitación del electrón y la generación de un nuevo fotón en la dispersión de Compton obedecían a una causalidad del orden de 10 ps. Como consecuencia, Bohr y sus colegas dieron a su modelo «un funeral tan honorable como fue posible».[23] En cualquier caso, el modelo BKS inspiró a Werner Heisenberg en su desarrollo[26] de la mecánica cuántica.

Unos cuantos físicos persistieron[27] en el desarrollo de modelos semiclásicos, en los cuales la radiación electromagnética no estaba cuantizada, aunque la materia obedecía las leyes de la mecánica cuántica. Aunque la evidencia de los fotones, a partir de los experimentos físicos y químicos, era aplastante hacia 1970, esta evidencia no podía considerarse absolutamente definitiva; puesto que recaía en la interacción de la luz con la materia, una teoría de la materia suficientemente complicada podía explicar la evidencia. Sin embargo, todas las teorías semiclásicas fueron refutadas definitivamente en los años 70 y 80 del siglo XX por elegantes experimentos de correlación de fotones.[28] [29] [30] Con ellos, se consideró probada la hipótesis de Einstein que indicaba que la cuantización era una propiedad intrínseca de la luz.

[editar] Dualidad onda-corpúsculo y principio de incertidumbre

Los fotones, como todos los objetos cuánticos, presentan tanto propiedades ondulatorias como corpusculares. Su naturaleza dual onda-partícula puede ser difícil de visualizar. El fotón muestra sus propiedades ondulatorias en fenómenos como la difracción y las interferencias. Por ejemplo, en un experimento de la doble rejilla, un fotón individual pasando a través de éstas incidiría en la pantalla con una distribución de probabilidad dada por sus patrones de interferencia determinados por las ecuaciones de Maxwell.[31] Sin embargo, los experimentos confirman que el fotón no es un corto pulso de radiación electromagnética; no se dispersa al propagarse, ni se divide al encontrarse con un divisor de haz. En vez de esto, el fotón se comporta como una partícula puntual, puesto que es absorbido o emitido en su conjunto por sistemas arbitrariamente pequeños, sistemas mucho más pequeños que sus longitudes de onda, tales como un núcleo atómico (≈10–15 m de diámetro) o incluso un electrón. Sin embargo, el fotón no es una partícula puntual cuya trayectoria sea determinada probabilísticamente por el campo electromagnético, según fue concebido por Einstein y otros; esa hipótesis fue también refutada por los experimentos de correlación de fotones ya mencionados anteriormente. De acuerdo con los conocimientos actuales, los propios campos electromagnéticos son producidos por fotones, los cuales a su vez resultan de una simetría de gauge local y las leyes de la teoría cuántica de campos.

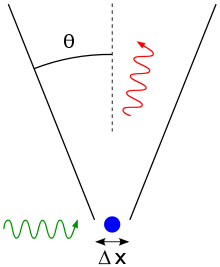

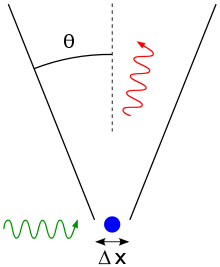

Experimento mental de

Heisenberg para localizar un

electrón (representado en azul) con un microscopio de rayos gamma de alta resolución. El

rayo gamma incidente (mostrado en verde) es desviado hacia arriba por el electrón dentro de la

apertura angular θ del microscopio. El rayo gamma desviado se muestra en rojo.

La óptica clásica demuestra que la posición del electrón sólo puede determinarse con una incertidumbre

Δx que depende de

θ y de la

longitud de onda λ del rayo de luz incidente.

Un elemento clave de la mecánica cuántica es el principio de incertidumbre de Heisenberg, que prohíbe el conocimiento simultáneo de la posición y el momento lineal de una partícula. Hay que destacar que el principio de incertidumbre para partículas materiales cargadas, requiere la cuantización de la luz en fotones, e incluso que la energía y el momento lineal de los fotones dependan de la frecuencia.

Una ilustración elegante es el experimento mental de Heisenberg para localizar un electrón con un microscopio ideal.[32] La posición del electrón puede determinarse dentro de la resolución óptica del microscopio, que viene dada por la fórmula de óptica clásica

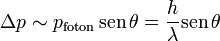

donde θ es la apertura angular del microscopio. Por tanto, la incertidumbre en la posición Δx puede hacerse arbitrariamente pequeña reduciendo la longitud de onda. El momento lineal del electrón es incierto, Δp, puesto que sufrió un “choque” con la luz que resultó desviada al interior del microscopio. Si la luz no estuviera cuantizada en fotones, la incertidumbre Δp podría hacerse arbitrariamente pequeña mediante la reducción de la intensidad de la luz. En ese caso, puesto que la longitud de onda y la intensidad de la luz pueden variarse de forma independiente, uno podría determinar de forma simultánea la posición y el momento lineal con una precisión arbitrariamente alta, violando el principio de incertidumbre. Como contraste, la fórmula de Einstein para el momento lineal del fotón preserva el principio de incertidumbre; puesto que el fotón es desviado a cualquier sitio dentro de la abertura, la incertidumbre del momento lineal transferido es

obteniéndose el producto  , que es el principio de incertidumbre de Heisenberg. De esta forma, todo resulta cuantizado; tanto la materia como los campos tienen que obedecer un conjunto consistente de leyes cuánticas, si alguno de ellos va a ser cuantizado.

, que es el principio de incertidumbre de Heisenberg. De esta forma, todo resulta cuantizado; tanto la materia como los campos tienen que obedecer un conjunto consistente de leyes cuánticas, si alguno de ellos va a ser cuantizado.

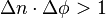

El principio de incertidumbre correspondiente para los fotones prohíbe la determinación simultánea del número  de fotones (véase estado de Fock y la sección Segunda cuantización más abajo) en una onda electromagnética y la fase

de fotones (véase estado de Fock y la sección Segunda cuantización más abajo) en una onda electromagnética y la fase  de esa onda

de esa onda

Tanto los fotones como las partículas materiales (p. ej.: los electrones) crean patrones de interferencia análogos cuando pasan por una doble rendija. Para los fotones, esto corresponde a la interferencia de una onda electromagnética de Maxwell mientras que, para partículas materiales, corresponde a la interferencia de la ecuación de ondas de Schrödinger. Aunque esta similitud podría sugerir que las ecuaciones de Maxwell son simplemente la ecuación de Schrödinger para los fotones, la mayoría de los físicos no están de acuerdo con esto.[33] [34] Por un lado, son matemáticamente diferentes; lo más obvio es que la ecuación de Schrödinger se resuelve para un campo complejo, mientras que las cuatro ecuaciones de Maxwell se resuelven para campos reales. Con mayor generalidad, el concepto habitual de una función de onda de probabilidad de Schrödinger no puede aplicarse a los fotones.[35] Al no tener masa, no pueden localizarse sin ser destruidos; técnicamente, los fotones no pueden tener un eigenestado de posición  , y, por tanto, el principio de incertidumbre habitual de Heisenberg ΔxΔp > h / 2 no es aplicable a los fotones. Se han sugerido algunas funciones de onda sustitutorias para el fotón,[36] [37] [38] [39] pero no han llegado a usarse de forma generalizada. En su lugar, los físicos aceptan generalmente la teoría de la segunda cuantización de los fotones que se describirá más abajo, en la cual los fotones son excitaciones cuantizadas de modos electromagnéticos.

, y, por tanto, el principio de incertidumbre habitual de Heisenberg ΔxΔp > h / 2 no es aplicable a los fotones. Se han sugerido algunas funciones de onda sustitutorias para el fotón,[36] [37] [38] [39] pero no han llegado a usarse de forma generalizada. En su lugar, los físicos aceptan generalmente la teoría de la segunda cuantización de los fotones que se describirá más abajo, en la cual los fotones son excitaciones cuantizadas de modos electromagnéticos.

[editar] Modelo de Bose-Einstein de un gas de fotones

En 1924, Satyendra Nath Bose derivó la ley de Planck de la radiación del cuerpo negro sin utilizar el electromagnetismo, mediante una especie de recuento en el espacio de fase.[40] Einstein demostró que esta modificación era equivalente a asumir que los fotones son rigurosamente idénticos y que ello implicaba una "misteriosa interacción no local",[41] [42] ahora entendida como la exigencia de un estado simétrico mecánico cuántico. Este trabajo dio lugar al concepto de los estados coherentes y al desarrollo del láser. En los mismos artículos, Einstein amplió el formalismo de Bose a partículas no materiales (bosones), y predijo que a temperaturas lo suficientemente bajas se condensarían en su estado cuántico fundamental; este condensado de Bose-Einstein se observó experimentalmente en 1995.[43]

Los fotones deben obedecer la estadística de Bose-Einstein si van a permitir el principio de superposición de los campos electromagnéticos, la condición es que las ecuaciones de Maxwell sean lineales. Todas las partículas se dividen en fermiones y bosones, en función de si su espín es semi-entero o entero respectivamente. El teorema de la estadística del espín pone de manifiesto que todos los bosones deben obedecer la estadística de Bose-Einstein, mientras que todos los fermiones obedecen la estadística de Fermi-Dirac o, de forma equivalente, el principio de exclusión de Pauli, que establece que, como máximo, una única partícula puede ocupar un estado cuántico. Así, si el fotón fuera un fermión, en un instante de tiempo sólo un fotón podría moverse en una dirección determinada. Esto es incompatible con la observación experimental de que los láseres pueden producir luz coherente de intensidad arbitraria, es decir, con muchos fotones desplazándose en la misma dirección. Por lo tanto, el fotón debe ser un bosón y obedecer la estadística de Bose-Einstein.

[editar] Emisión estimulada y espontánea

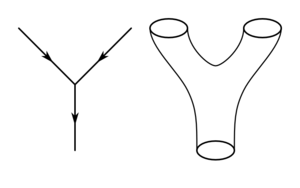

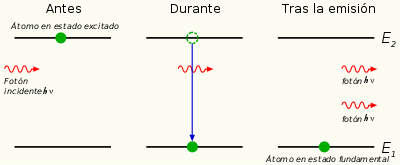

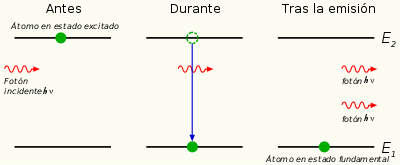

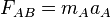

Emisión estimulada (en la cual los fotones se "clonan" a si mismos) fue predicho por Einstein en su derivación de E=hν, y condujo al desarrollo del láser.

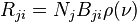

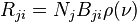

En 1916, Einstein demostró que la hipótesis cuántica de Planck E = hν podría derivarse de un tipo de ecuación cinética.[5] Considere una cavidad en equilibrio térmico y llena de radiación electromagnética y de sistemas que pueden emitir y absorber la radiación. El equilibrio térmico requiere que la densidad ρ(ν) de fotones con frecuencia ν sea constante en el tiempo, por lo cual, la tasa de emisión de fotones a una determinada frecuencia debe ser igual a la tasa de absorción de ellos.

Einstein teorizó que el ritmo de absorción de un fotón de frecuencia ν y transicionar de un estado de energía más bajo Ej a otro más alto Ei era proporcional al número Nj de moléculas con energía Ej y a la densidad ρ(ν) de fotones en el ambiente con tal frecuencia.

donde Bji es la constante para el ritmo de absorción Rji de los niveles energéticos Ej a Ei.

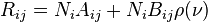

De manera más atrevida, Einstein teorizó que el ritmo inverso Rij para que el sistema emitiera un fotón de frecuencia ν y transicionara desde Ei a Ej se componía de dos términos:

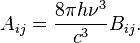

donde Aij es el ritmo de emisión espontánea de un fotón y Bij es la constante para el ritmo de emisión en respuesta a los fotones presentes en el ambiente (emisión inducida o estimulada). Einstein demostró que la fórmula de Planck E = hν es una consecuencia necesaria de estas dos ecuaciones teóricas y de los requerimientos básicos de que la radiación ambiente esté en equilibrio térmico con los sistemas que absorben y emiten la radiación y que sea independiente de la composición del material del sistema.

Este sencillo modelo cinético fue un estímulo poderoso para la investigación. Einstein pudo mostrar que Bij = Bji, esto es ambas constantes para los ritmos de absorción y emisión inducida eran iguales, y más sorprendente aún:

Einstein no trató de justificar sus dos ecuaciones pero hizo notar que Aij y Bij deberían poder derivarse de la mecánica y la electrodinámica modificadas para acomodadar la hipótesis cuántica. Esta predicción fue confirmada en la mecánica cuántica y en la electrodinámica cuántica, respectivamente, y ambas son necesarias para obtener las constantes de velocidad de Einstein a partir de primeros principios. Paul Dirac derivó las constantes de velocidad Bij en 1926 utilizando un enfoque semiclásico,[44] y, en 1927, logró derivar todas las constantes de velocidad a partir de primeros principios.[45] [46]

El trabajo de Dirac representó el fundamento de la electrodinámica cuántica, es decir, la cuantización del mismo campo electromagnético. El enfoque de Dirac también se le llama segunda cuantización o teoría cuántica de campos,[47] [48] [49] la anterior mecánica cuántica (la cuantificación de las partículas materiales moviéndose en un potencial) representa la "primera cuantización".

[editar] Segunda cuantización

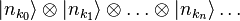

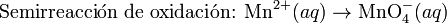

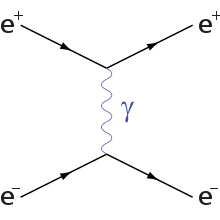

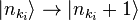

Diferentes

modos electromagnéticos (como los descritos aquí) pueden tratarse como

osciladores armónicos simples independientes. Un fotón corresponde a una unidad de energía

E = hν en su modo electromagnético.

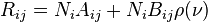

En 1910, Peter Debye dedujo la ley de Planck de radiación de un cuerpo negro a partir de una suposición relativamente simple.[50] Descompuso correctamente el campo electromagnético en una cavidad, en sus modos de Fourier, y asumió que la energía en cualquier modo era un múltiplo entero de hν, donde ν es la frecuencia del modo electromagnético. La ley de Planck de la radiación del cuerpo negro se obtiene inmediatamente como una suma geométrica. Sin embargo, la aproximación de Debye falló a la hora de dar la fórmula correcta para las fluctuaciones de energía de la radiación del cuerpo negro, que fue obtenida por Einstein en 1909.[4]

En 1925, Born, Heisenberg y Jordan reinterpretaron el concepto de Debye en una forma clave.[51] Como puede demostrarse clásicamente, los modos de Fourier del campo electromagnético —un conjunto completo de ondas electromagnéticas planas caracterizadas por sus vectores de onda k y sus estados de polarización— son equivalentes a un conjunto de osciladores armónicos simples desacoplados. Tratado de un modo mecano-cuántico, se demuestra que los niveles de energía de dichos osciladores son E = nhν, donde ν es la frecuencia del oscilador. El paso clave fue identificar un modo electromagnético con energía E = nhν, como un estado con n fotones, cada uno de ellos con energía hν. Esta aproximación sí da la fórmula para la correcta fluctuación de energía.

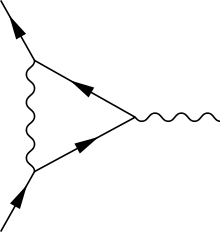

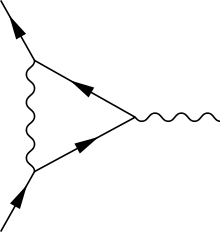

En la teoría de campos cuántica, la probabilidad de los eventos se calcula mediante la suma de todas las posibles formas en las que pueden suceder, como en el

diagrama de Feynman mostrado aquí.

Dirac dio un paso más.[45] [46] Él trató la interacción entre una carga y un campo electromagnético como una pequeña perturbación que induce transiciones en los estados de los fotones, cambiando el número de fotones de los modos, mientras se conservan la energía y el momento lineal total. Dirac pudo obtener los coeficientes Aij y Bij de Einstein a partir de los principios fundamentales, y demostró que la estadística de Bose-Einstein de los fotones es consecuencia natural de cuantizar correctamente los campos electromagnéticos (el razonamiento de Bose fue en el sentido opuesto; él dedujo la ley de Planck de la radiación del cuerpo negro a partir de la estadística de BE). En la época de Dirac, no era aún conocido que todos los bosones, incluidos los fotones, tienen que obedecer la estadística de BE.

La teoría de perturbaciones de segundo orden de Dirac puede involucrar a fotones virtuales, estados intermedios transitorios del campo electromagnético; dichos fotones virtuales actúan como mediadores en la electricidad estática y las interacciones magnéticas. En la teoría cuántica de campos, la amplitud de probabilidad de eventos observables se calcula mediante la suma de todos los posibles pasos intermedios, incluso aquellos que son no-fisicos; por tanto, los fotones virtuales no se limitan a satisfacer E = pc, y pueden tener estados de polarización extra; dependiendo del gauge utilizado, los fotones virtuales pueden tener tres o cuatro estados de polarización, en lugar de los dos estados de los fotones reales. Aunque estos fotones virtuales transitorios nunca pueden ser observados, contribuyen de forma apreciable a las probabilidades de eventos observables. De hecho, dichos cálculos de perturbaciones de segundo orden y órdenes superiores pueden proporcionar aparentemente infinitas contribuciones a la suma. Los resultados no-físicos se corrigen mediante técnicas de renormalización. Otras partículas virtuales pueden contribuir también a la suma; por ejemplo, dos fotones pueden interaccionar de forma indirecta por medio de pares electrón-positrón virtuales.

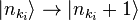

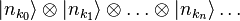

En notación de física moderna, el estado cuántico del campo electromagnético se escribe como un estado de Fock, un producto tensorial de los estados para cada modo electromagnético

donde  representa el estado en el cual

representa el estado en el cual  fotones están en el modo ki. En esta notación, la creación de un nuevo fotón en modo ki (p. ej., el emitido desde una transición atómica) se escribe como

fotones están en el modo ki. En esta notación, la creación de un nuevo fotón en modo ki (p. ej., el emitido desde una transición atómica) se escribe como  . Esta notación simplemente expresa el concepto de Born, Heisenberg y Jordan descrito arriba, y no añade nada de física.

. Esta notación simplemente expresa el concepto de Born, Heisenberg y Jordan descrito arriba, y no añade nada de física.

[editar] El fotón como un bosón gauge

El campo electromagnético se puede entender por medio de una teoría gauge como un campo resultado de exigir que unas simetrías sean independientes para cada posición en el espacio-tiempo.[52] Para el campo electromagnético, esta simetría es la simetría Abeliana U(1) de los números complejos, que refleja la capacidad de variar la fase de un número complejo sin afectar números reales construidos del mismo, tales como la energía o el lagrangiano.

El cuanto en el campo gauge abeliano debe ser tipo bosón sin carga ni masa, mientras no se rompa la simetría; por ello se predice que el fotón no tiene masa, y tener cero carga eléctrica y spin entero. La forma particular de la interacción electromagnética especifica que el fotón debe tener spin ± 1, por lo que su helicidad debe ser  . Estos dos componentes del spin corresponden a los conceptos clásicos de luz polarizada circularmente a la derecha y a la izquierda.

. Estos dos componentes del spin corresponden a los conceptos clásicos de luz polarizada circularmente a la derecha y a la izquierda.

En el Modelo estándar de física de partículas, el fotón es una de los cuatro bosones gauge en la interacción electrodébil, siendo los otros tres los bosones W+, W− y Z0 que son responsables de la interacción débil. A diferencia de los fotones, estos bosones tienen una masa invariante debido a un mecanismo que rompe su simetría gauge SU(2) particular. La unificación de los fotones con los mencionados bosones en la interacción electrodébil fue realizada por Sheldon Glashow, Abdus Salam y Steven Weinberg, por el que fueron galardonados con el Premio Nobel de física 1979.[53] [54] [55]

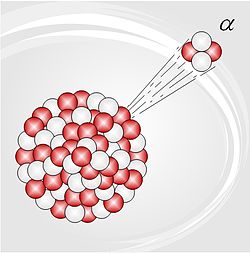

Los físicos continúan buscando hipótesis sobre grandes teorías de unificación que conecten estos cuatro bosones gauge con los ocho bosones gauge gluones de la cromodinámica cuántica. Sin embargo, varias predicciones importantes de estas teorías, tales como la desintegración de protones, no se han observado experimentalmente.

[editar] Estructura del fotón

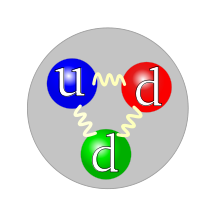

De acuerdo con la cromodinámica cuántica, un fotón real puede interactuar como una partícula puntual, o como una colección de quarks y gluones, esto es, como un hadrón. La estrucutra de los fotones no se determina por las tradicionales distribuciones de quarks de valencia como en un protón, sino por fluctuaciones del fotón puntual en una colección de partones.[56]

[editar] Contribución a la masa de un sistema

La energía de un sistema que emite un fotón se reduce en una cantidad igual a la energía E del fotón medida en el sistema de referencia en reposo del sistema emisor, lo cual resulta en una reducción de la masa por un valor E / c2. Del mismo modo, la masa de un sistema que absorbe un fotón se incrementa por la misma cantidad correspondiente.

Este concepto se aplica en un factor clave predicho por la QED, la teoría de la electrodinámica cuántica iniciada por Dirac (descrita anteriormente). QED es capaz de predecir el momento dipolar magnético de los leptones con una exactitud muy alta; las mediciones experimentales de los momentos de los dipolos magnéticos están perfectamente de acuerdo con estas predicciones. Las predicciones, sin embargo, requieren contar las contribuciones de fotones virtuales a la masa del leptón. Otro ejemplo de este tipo de contribuciones que están comprobadas experimentalmente es la predicción de la QED del efecto Lamb observado en la estructura hiperfina de pares de leptones ligados, tales como el muonio y el positronio.

Dado que los fotones contribuyen al tensor de energía-impulso, ejercen una atracción gravitatoria sobre otros objetos, de acuerdo con la teoría general de la relatividad. A su vez, la gravedad afecta los fotones; normalmente sus trayectorias rectas pueden ser dobladas por un espacio-tiempo deformado, como ocurre en las lentes gravitacionales, y sus frecuencias disminuyen al pasar a un potencial gravitatorio más alto, como en el experimento de Pound y Rebka. Sin embargo, estos efectos no son específicos de los fotones; los mismos efectos se predecirían para las ondas electromagnéticas clásicas.

[editar] Fotones y materia

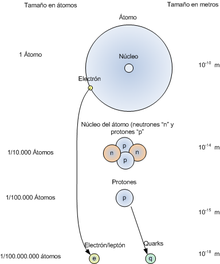

Nombre y carga eléctrica de los componentes de la materia.

La luz que viaja a través de materia transparente, lo hace a una velocidad menor que c, la velocidad de la luz en el vacío. Por ejemplo, los fotones en su viaje desde el centro del Sol sufren tantas colisiones, que la energía radiante tarda aproximadamente un millón de años en llegar a la superficie;[57] sin embargo, una vez en el espacio abierto, un fotón tarda únicamente 8,3 minutos en llegar a la Tierra. El factor por el cual disminuye la velocidad se conoce como índice de refracción del material. Desde la óptica clásica, la reducción de velocidad puede explicarse a partir de la polarización eléctrica que produce la luz en la materia: la materia polarizada radia nueva luz que interfiere con la luz original para formar una onda retardada. Viendo al fotón como una partícula, la disminución de la velocidad puede describirse en su lugar como una combinación del fotón con excitaciones cuánticas de la materia (cuasipartículas como fonones y excitones) para formar un polaritón; este polaritón tiene una masa efectiva distinta de cero, lo que significa que no puede viajar con velocidad c. Las diferentes frecuencias de la luz pueden viajar a través de la materia con distintas velocidades; esto se conoce como dispersión. La velocidad de propagación del polaritón v es igual a su velocidad de grupo, que es la derivada de la energía con respecto al momento lineal.

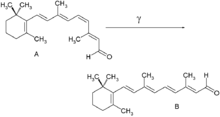

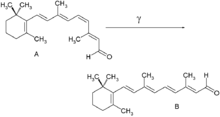

Transformación en el

retinal tras la absorción de un fotón γ de longitud de onda correcta.

donde, E y p son la energía y el módulo del momento lineal del polaritón, y ω y k son su frecuencia angular y número de onda, respectivamente. En algunos casos, la dispersión puede dar lugar a velocidades de la luz extremadamente lentas. Los efectos de las interacciones de los fotones con otras cuasipartículas puede observarse directamente en la dispersión Raman y la dispersión Brillouin.

Los fotones pueden también ser absorbidos por núcleos, átomos o moléculas, provocando transiciones entre sus niveles de energía. Un ejemplo clásico es la transición molecular del retinal (C20H28O, figura de la derecha), que es responsable de la visión, como descubrieron el premio Nobel George Wald y su colaboradores en 1958. Como se muestra aquí, la absorción provoca una isomerización cis-trans que, en combinación con otras transiciones, dan lugar a impulsos nerviosos. La absorción de fotones puede incluso romper enlaces químicos, como en la fotólisis del cloro; éste es un tema de fotoquímica.

[editar] Aplicaciones tecnológicas

Los fotones tienen muchas aplicaciones en tecnología. Se han elegido ejemplos que ilustran las aplicaciones de los fotones per se, y no otros dispositivos ópticos como lentes, etc. cuyo funcionamiento puede explicarse bajo una teoría clásica de la luz. El láser es una aplicación extremadamente importante.

Los fotones individuales pueden detectarse por varios métodos. El tubo fotomultiplicador clásico se basa en el efecto fotoeléctrico; un fotón que incide sobre una lámina de metal arranca un electrón, que inicia a su vez una avalancha de electrones. Los circuitos integrados CCD utilizan un efecto similar en semiconductores; un fotón incidente genera una carga detectable en un condensador microscópico. Otros detectores como los contadores Geiger utilizan la capacidad de los fotones para ionizar moléculas de gas, lo que da lugar a un cambio detectable en su conductividad.

La fórmula de la energía de Planck E = hν es utilizada a menudo por ingenieros y químicos en diseño, tanto para calcular el cambio de energía resultante de la absorción de un fotón, como para predecir la frecuencia de la luz emitida en una transición de energía dada. Por ejemplo, el espectro de emisión de una lámpara fluorescente puede diseñarse utilizando moléculas de gas con diferentes niveles de energía electrónica y ajustando la energía típica con la cual un electrón choca con las moléculas de gas en el interior de la lámpara.

Bajo algunas condiciones, se puede excitar una transición de energía por medio de dos fotones, no ocurriendo dicha transición con los fotones por separado. Esto permite microscopios con mayores resoluciones, porque la muestra absorbe energía únicamente en la región en la que los dos rayos de colores diferentes se solapan de forma significativa, que puede ser mucho menor que el volumen de excitación de un rayo individual. Además, estos fotones causan un menor daño a la muestra, puesto que son de menor energía.

En algunos casos, pueden acoplarse dos transiciones de energía de modo que, cuando un sistema absorbe un fotón, otro sistema cercano roba su energía y re-emite un fotón con una frecuencia diferente. Esta es la base de la transferencia de energía por resonancia entre moléculas fluorescentes, que se utiliza para medir distancias moleculares.

[editar] Investigación reciente

Actualmente se cree comprender teóricamente la naturaleza fundamental del fotón. El modelo estándar predice que el fotón es un bosón de gauge de spin 1, sin masa ni carga, que media la interacción electromagnética y que resulta de la simetría gauge local U(1). Sin embargo, los físicos continúan buscando discrepancias entre los experimentos y las predicciones del modelo estándar, buscando nuevas posibilidades para la física más allá del modelo estándar. En particular, hay cotas de mayor precisión en los experimentos para los límites superiores para una hipotética carga y masa del fotón. Hasta ahora, todos los datos experimentales son consistentes con el fotón de carga y masa cero[11] [58] Los límites superiores aceptados universalmente en la carga y masa del fotón son 5×10−52 C (o 3×10−33 por la carga elemental) y 1.1×10−52 kg (6×10-17 eV/c2), respectivamente.[59]

Se ha investigado mucho las posibles aplicaciones de los fotones en óptica cuántica. Los fotones parecen adecuados como elementos de un ordenador cuántico, y el entrelazamiento cuántico de los fotones es un campo de investigación. Otra área de investigación activa son los procesos ópticos no lineales, con tópicos tales como la absorción de dos fotones, auto modulación de fases y los osciladores ópticos parametrizados. Finalmente, los fotones son esenciales en algunos aspectos de la comunicación óptica, especialmente en criptografía cuántica.

[editar] Véase también

[editar] Referencias y notas al pie

- ↑ a b a diferencia de otras partículas como el electrón o el quark. Debido a los resultados de experimentos y a consideraciones teóricas descritas en este artículo, se cree que la masa del fotón es exactamente cero. Algunas fuentes utilizan también el concepto de masa relativista para la energía expresada con unidades de masa. Para un fotón con longitud de onda λ o energía E, su masa relativista es h/λc o E/c2. Este uso del término "masa" no es común actualmente en la literatura científica.

- ↑ Vimal, R. L. P., Pokorny, J., Smith, V. C., & Shevell, S. K. (1989). Foveal cone thresholds. Vision Res, 29(1), 61-78.http://www.geocities.com/vri98/Vimal-foveal-cone-ratio-VR-1989 (en inglés)

- ↑ a b c d e Einstein, A (1905). «Über einen die Erzeugung und Verwandlung des Lichtes betreffenden heuristischen Gesichtspunkt (trad. Modelo heurístico de la creación y transformación de la luz)». Annalen der Physik 17: pp. 132–148 (en alemán). Una traducción inglesa del trabajo de Einstein se encuentra disponible en Wikisource.

- ↑ a b c d Einstein, A (1909). «Über die Entwicklung unserer Anschauungen über das Wesen und die Konstitution der Strahlung (trad. Evolución de nuestro concepto sobre la composición y esencia de la radiación)». Physikalische Zeitschrift 10: pp. 817–825 (en alemán). Una traducción inglesa se encuentra disponible en Wikisource.

- ↑ a b Einstein, A (1916a). «Strahlungs-emission und -absorption nach der Quantentheorie». Verhandlungen der Deutschen Physikalischen Gesellschaft 18: pp. 318 (en alemán).

- ↑ a b Einstein, A (1916b). «Zur Quantentheorie der Strahlung». Mitteilungen der Physikalischen Geselschaft zu Zürich 16: pp. 47. También Physikalische Zeitschrift, 18, 121–128 (1917) (en alemán).

- ↑ Lewis, GN (1926). «The conservation of photons». Nature 118: pp. 874–875. (en inglés)

- ↑ Villard, P (1900). «Sur la réflexion et la réfraction des rayons cathodiques et des rayons déviables du radium». Comptes Rendus 130: pp. 1010–1012. (en francés)

- ↑ Villard, P (1900). «Sur le rayonnement du radium». Comptes Rendus 130: pp. 1178–1179. (en francés)

- ↑ Rutherford, E; Andrade ENC (1914). «The Wavelength of the Soft Gamma Rays from Radium B». Philosophical Magazine 27: pp. 854–868. (en inglés)

- ↑ a b Kobychev, V V; Popov, S B (2005). «Constraints on the photon charge from observations of extragalactic sources». Astronomy Letters 31: pp. 147–151. doi:10.1134/1.1883345. (en inglés)

- ↑ Descartes, R (1637). Discours de la méthode (Discurso sobre método). (en francés)

- ↑ Hooke, R (1665). ' "Micrographia: or some physiological descriptions of minute bodies made by magnifying glasses with observations and inquiries thereupon.... http://digital.library.wisc.edu/1711.dl/HistSciTech.HookeMicro '. (en inglés)

- ↑ Huygens, C (1678). Traite de la lumiere (trans. Treatise on Light). (en francés)

- ↑ Newton, I (1730). Opticks (4th edition edición). Dover Publications. pp. Book II, Part III, Propositions XII–XX; Queries 25–29. ISBN 0-486-60205-2. (en inglés)

- ↑ Buchwald, Jed Z. (1989). The Rise of the Wave Theory of Light: Optical Theory and Experiment in the Early Nineteenth Century. University of Chicago Press. ISBN 0-226-07886-8. (en inglés)

- ↑ Maxwell, JC (1865). «A Dynamical Theory of the Electromagnetic Field». Philosophical Transactions of the Royal Society of London 155: pp. 459–512. Este artículo siguió a una presentacion de Maxwell en la Royal Society el 8 de diciembre de 1864.

- ↑ Hertz, H (1888). «Über Strahlen elektrischer Kraft». Sitzungsberichte der Preussischen Akademie der Wissenschaften (Berlin) 1888: pp. 1297–1307. (en alemán)

- ↑ a b «Wilhelm Wien Nobel Lecture». Pronunciado el 11 de diciembre de 1911.(en inglés)

- ↑ Planck, M (1901). «Über das Gesetz der Energieverteilung im Normalspectrum». Annalen der Physik 4: pp. 553–563. (en alemán)

- ↑ a b «Max Planck's Nobel Lecture». (en alemán) Publicada 2 de junio 1920.

- ↑ a b Compton, A (1923). «A Quantum Theory of the Scattering of X-rays by Light Elements». Physical Review 21: pp. 483–502. (en inglés)

- ↑ a b Pais, A (1982). Subtle is the Lord: The Science and the Life of Albert Einstein. Oxford University Press. (en inglés)

- ↑ a b «Robert A. Millikan's Nobel Lecture». (en inglés) publicada el 23 de mayo de 1924.

- ↑ Bohr, N; Kramers HA and Slater JC (1924). «The Quantum Theory of Radiation». Philosophical Magazine 47: pp. 785–802. También Zeitschrift für Physik, 24, 69 (1924).

- ↑ Heisenberg Nobel lecture, publicado 11 de diciembre 1933.

- ↑ Mandel, L (1976). E. Wolf, ed.. ed. «The case for and against semiclassical radiation theory». Progress in Optics (North-Holland) XIII: pp. 27–69.

- ↑ Clauser, JF. (1974). Experimental distinction between the quantum and classical field-theoretic predictions for the photoelectric effect. Phys. Rev. D 9: 853–860.

- ↑ Kimble, HJ; Dagenais M, and Mandel L. (1977). Photon Anti-bunching in Resonance Fluorescence. Phys. Rev. Lett. 39: 691–695.

- ↑ Grangier, P; Roger G, and Aspect A. (1986). Experimental Evidence for a Photon Anticorrelation Effect on a Beam Splitter: A New Light on Single-Photon Interferences. Europhysics Letters 1: 501–504.

- ↑ Taylor, GI (1909). «Interference fringes with feeble light». Proceedings of the Cambridge Philosophical Society 15: pp. 114–115.

- ↑ Heisenberg, W (1927). «Über den anschaulichen Inhalt der quantentheoretischen Kinematik und Mechanik». Zeitschrift für Physik 43: pp. 172–198. (en alemán)

- ↑ Kramers, HA (1958). Quantum Mechanics. Amsterdam: North-Holland.

- ↑ Bohm, D (1954). Quantum Theory. London: Constable.

- ↑ Newton, TD; Wigner EP (1949). «Localized states for elementary particles». Reviews of Modern Physics 21: pp. 400–406.

- ↑ Bialynicki-Birula, I (1994). «On the wave function of the photon». Acta Physica Polonica A 86: pp. 97–116.

- ↑ Sipe, JE (1995). «Photon wave functions». Physical Review A 52: pp. 1875–1883.

- ↑ Bialynicki-Birula, I (1996). «Photon wave function». Progress in Optics 36: pp. 245–294.

- ↑ Scully, MO; Zubairy MS (1997). Quantum Optics. Cambridge: Cambridge University Press.

- ↑ Bose, SN (1924). «Plancks Gesetz und Lichtquantenhypothese». Zeitschrift für Physik 26: pp. 178–181. (en alemán)

- ↑ Einstein, A (1924). «Quantentheorie des einatomigen idealen Gases». Sitzungsberichte der Preussischen Akademie der Wissenschaften (Berlin), Physikalisch-mathematische Klasse 1924: pp. 261–267. (en alemán)

- ↑ Einstein, A (1925). «Quantentheorie des einatomigen idealen Gases, Zweite Abhandlung». Sitzungsberichte der Preussischen Akademie der Wissenschaften (Berlin), Physikalisch-mathematische Klasse 1925: pp. 3–14. (en alemán)

- ↑ Anderson, MH; Ensher JR, Matthews MR, Wieman CE, and Cornell EA (1995). «Observation of Bose–Einstein Condensation in a Dilute Atomic Vapor». Science 269: pp. 198–201. http://links.jstor.org/sici?sici=0036-8075%2819950714%293%3A269%3A5221%3C198%3AOOBCIA%3E2.0.CO%3B2-G.

- ↑ Dirac, PAM (1926). «On the Theory of Quantum Mechanics». Proc. Roy. Soc. A 112: pp. 661–677. (en inglés)

- ↑ a b Dirac, PAM (1927a). «The Quantum Theory of the Emission and Absorption of Radiation». Proc. Roy. Soc. A 114: pp. 243–265.

- ↑ a b Dirac, PAM (1927b). «The Quantum Theory of Dispersion». Proc. Roy. Soc. A 114: pp. 710–728. (en inglés)

- ↑ Heisenberg, W; Pauli W (1929). «Zur Quantentheorie der Wellenfelder». Zeitschrift für Physik 56: pp. 1. (en alemán)

- ↑ Heisenberg, W; Pauli W (1930). «Zur Quantentheorie der Wellenfelder». Zeitschrift für Physik 59: pp. 139. (en alemán)

- ↑ Fermi, E (1932). «Quantum Theory of Radiation». Reviews of Modern Physics 4: pp. 87.

- ↑ Debye, P (1910). «Der Wahrscheinlichkeitsbegriff in der Theorie der Strahlung». Annalen der Physik 33: pp. 1427–34. Plantilla:En alemán

- ↑ Born, M; Heisenberg W and Jordan P (1925). «Quantenmechanik II». Zeitschrift für Physik 35: pp. 557–615. Plantilla:En alemán

- ↑ Ryder, LH (1996). Quantum field theory (2nd edition edición). Cambridge University Press. ISBN 0-521-47814-6.

- ↑ Dicurso de Sheldon Glashow, dado el 8 Diciembre 1979.

- ↑ Dicurso de Abdus Salam, dado el 8 Diciembre 1979.

- ↑ Dicurso de Steven Weinberg, dado el 8 Diciembre 1979.

- ↑ QCD and Two-Photon Physics, in Linear Collider Physics Resource Book for Snowmass 2001, Chapter 7, LC-REV-2001-074-US.(en inglés)

- ↑ Robert Naeye (1998). (en inglés) Through the Eyes of Hubble: Birth, Life and Violent Death of Stars. CRC Press. ISBN 0750304847. http://books.google.com/books?id=06_9B7S_q_YC&pg=PA16&dq=million-year+surface+sun+photon&as_brr=3&ei=gYsyR6iELpLgtgOkttmvAQ&sig=70D3g1ajnoVyvnoY1qBAIV0yIf4 (en inglés).

- ↑ (a) Goldhaber, AS (1971). «Terrestrial and Extraterrestrial Limits on The Photon Mass». Reviews of Modern Physics 43: pp. 277–96..

(b) Fischbach, E; Kloor H, Langel RA, Lui ATY, and Peredo M (1994). «New Geomagnetic Limits on the Photon Mass and on Long-Range Forces Coexisting with Electromagnetism». Physical Review Letters 73: pp. 514–17..

(c) Official particle table for gauge and Higgs bosons S. Eidelman et al. (Particle Data Group) Physics Letters B 592, 1 (2004)

(d) Davis, L; Goldhaber AS and Nieto MM (1975). «Limit on Photon Mass Deduced from Pioneer-10 Observations of Jupiter's Magnetic Field». Physical Review Letters 35: pp. 1402–1405..

(e) Luo, J; Shao CG, Liu ZZ, and Hu ZK (1999). «Determination of the limit of photon mass and cosmic magnetic vector with rotating torsion balance». Physical Review A 270: pp. 288–292..

(f) Schaeffer, BE (1999). «Severe limits on variations of the speed of light with frequency». Physical Review Letters 82: pp. 4964–4966..

(g) Luo, J; Tu LC, Hu ZK, and Luan EJ (2003). «New experimental limit on the photon rest mass with a rotating torsion balance». Physical Review Letters 90: pp. Art. No. 081801.

(h) Williams, ER; Faller JE and Hill HA (1971). «New Experimental Test of Coulomb's Law: A Laboratory Upper Limit on the Photon Rest Mass». Physical Review Letters 26: pp. 721–724.

(i) Lakes, R (1998). «Experimental Limits on the Photon Mass and Cosmic Magnetic Vector Potential». Physical Review Letters 80: pp. 1826.

(j) 2006 PDG listing for photon W.-M. Yao et al. (Particle Data Group) Journal of Physics G 33, 1 (2006).

(k) Adelberger, E; Dvali, G and Gruzinov, A. «Photon Mass Bound Destroyed by Vortices». Physical Review Letters 98: pp. Art. No. 010402. - ↑ Tabla oficial de partículas para bosones gauge y de Higgs

[editar] Enlaces externos

Obtenido de "http://es.wikipedia.org/wiki/Fot%C3%B3n"

[1]

[1]

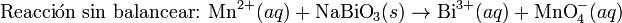

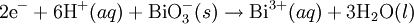

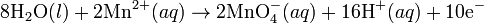

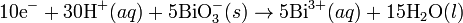

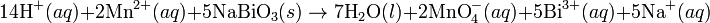

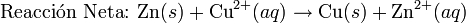

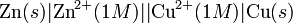

por que el el potencial estándar de reducción es una propiedad intensiva.

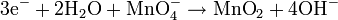

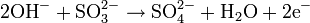

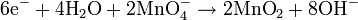

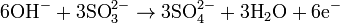

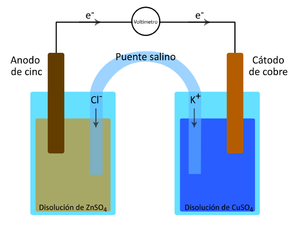

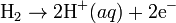

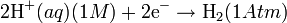

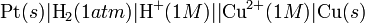

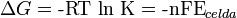

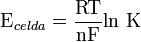

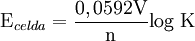

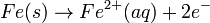

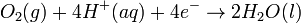

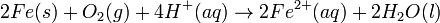

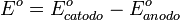

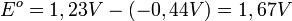

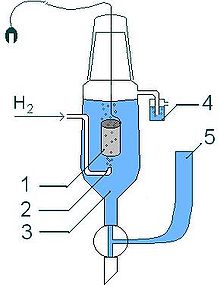

por que el el potencial estándar de reducción es una propiedad intensiva. con algunas cantidades termodinámicas permiten saber la espontaneidad de un proceso determinado. En una celda electroquímica toda la energía química se transforma en energía eléctrica. La carga eléctrica total que pasa a través de la celda es calculada por:

con algunas cantidades termodinámicas permiten saber la espontaneidad de un proceso determinado. En una celda electroquímica toda la energía química se transforma en energía eléctrica. La carga eléctrica total que pasa a través de la celda es calculada por:

la Constante de Faraday y

la Constante de Faraday y  el número de moles de e⁻. Como la fem es el potencial máximo de la celda y el trabajo eléctrico es la cantidad máxima de trabajo (

el número de moles de e⁻. Como la fem es el potencial máximo de la celda y el trabajo eléctrico es la cantidad máxima de trabajo ( ) que se puede hacer, se llega a la siguiente igualdad:

) que se puede hacer, se llega a la siguiente igualdad:

es negativo significa que hay energía libre y por lo tanto la reacción es espontanea. Para que ocurra eso el

es negativo significa que hay energía libre y por lo tanto la reacción es espontanea. Para que ocurra eso el  debe ser positivo. Caso contrario la reacción no procede. Para valores negativos de

debe ser positivo. Caso contrario la reacción no procede. Para valores negativos de  muy próximos a cero es posible que la reacción tampoco proceda debido a factores secundarios, como por ejemplo el fenómeno de sobretensión. Una reacción espontánea puede ser utilizada para generar energía eléctrica, no es nada más ni nada menos que una Pila de combustible. Mientras que a una reacción no espontánea se le debe aplicar un suficiente potencial eléctrico para que la misma se lleve a cabo. Este fenomeno es conocido como Electrólisis.[1] En una celda electroquímica, la relación entre la Constante de equilibrio, K, y la energía libre de Gibbs se puede expresar de la siguiente manera:

muy próximos a cero es posible que la reacción tampoco proceda debido a factores secundarios, como por ejemplo el fenómeno de sobretensión. Una reacción espontánea puede ser utilizada para generar energía eléctrica, no es nada más ni nada menos que una Pila de combustible. Mientras que a una reacción no espontánea se le debe aplicar un suficiente potencial eléctrico para que la misma se lleve a cabo. Este fenomeno es conocido como Electrólisis.[1] En una celda electroquímica, la relación entre la Constante de equilibrio, K, y la energía libre de Gibbs se puede expresar de la siguiente manera:

se obtiene:

se obtiene:

[1]

[1]

(la letra

(la letra  , que representa también la energía asociada a un fotón, donde

, que representa también la energía asociada a un fotón, donde  es la

es la  es la

es la  , siendo

, siendo  , en este caso, la frecuencia.

, en este caso, la frecuencia.

) entre un

) entre un  y su dirección de propagación. El fotón es el

y su dirección de propagación. El fotón es el

(conocida como

(conocida como  ) y

) y  es la

es la  , y la componente medida a lo largo de su dirección de movimiento, su

, y la componente medida a lo largo de su dirección de movimiento, su  . Estos dos posibles valores corresponden a los dos posibles estados de

. Estos dos posibles valores corresponden a los dos posibles estados de

, que es el principio de incertidumbre de Heisenberg. De esta forma, todo resulta cuantizado; tanto la materia como los campos tienen que obedecer un conjunto consistente de leyes cuánticas, si alguno de ellos va a ser cuantizado.

, que es el principio de incertidumbre de Heisenberg. De esta forma, todo resulta cuantizado; tanto la materia como los campos tienen que obedecer un conjunto consistente de leyes cuánticas, si alguno de ellos va a ser cuantizado. de fotones (véase

de fotones (véase  de esa onda

de esa onda

, y, por tanto, el principio de incertidumbre habitual de Heisenberg

, y, por tanto, el principio de incertidumbre habitual de Heisenberg

representa el estado en el cual

representa el estado en el cual  fotones están en el modo

fotones están en el modo  . Esta notación simplemente expresa el concepto de Born, Heisenberg y Jordan descrito arriba, y no añade nada de física.

. Esta notación simplemente expresa el concepto de Born, Heisenberg y Jordan descrito arriba, y no añade nada de física.

.

. .

. .

.

.

.

.

.

, un antiquark se escribe

, un antiquark se escribe  .

.