HISTORIA22: OCKHAM. LA NAVAJA DE OCKHAM. La navaja de Ockham (a veces escrito Occam u Ockam), principio de economía o principio de parsimonia, es un principio filosófico atribuido a Guillermo de Ockham (1280-1349), según el cual cuando dos teorías en igualdad de condiciones tienen las mismas consecuencias, la teoría más simple tiene más probabilidades de ser correcta que la compleja.

Navaja de Ockham

La navaja de Ockham (a veces escrito Occam u Ockam), principio de economía o principio de parsimonia, es un principio filosófico atribuido a Guillermo de Ockham (1280-1349), según el cual cuando dos teorías en igualdad de condiciones tienen las mismas consecuencias, la teoría más simple tiene más probabilidades de ser correcta que la compleja.[1]

En ciencia, esta teoría se utiliza como una regla general para guiar a los científicos en el desarrollo de modelos teóricos, más que como un árbitro entre los modelos publicados. En el método científico, la navaja de Ockham no se considera un principio irrefutable de la lógica, y ciertamente no es un resultado científico. "La explicación más simple y suficiente es la más probable, mas no necesariamente la verdadera", según el principio de Ockham. En ciertas ocasiones, la opción compleja puede ser la correcta. Su sentido es que a igualdad de condiciones, sean preferidas las teorías más simples. Otra cuestión diferente serán las evidencias que apoyen la teoría. Así pues, de acuerdo con este principio, una teoría más simple pero menos correcta no debería ser preferida a una teoría más compleja pero más correcta.

Qué ha de tenerse en cuenta para medir la simplicidad, sin embargo, es una cuestión ambigua.[1] Quizás la propuesta más conocida sea la que sugirió el mismo Ockham: cuando dos teorías tienen las mismas consecuencias, debe preferirse la teoría que postule la menor cantidad de (tipos de) entidades.[2] Otra manera de medir la simplicidad, sin embargo, podría ser por el número de axiomas de la teoría.[1]

La teoría de la navaja de Ockham se aplica a casos prácticos y específicos, englobándose dentro de los principios fundamentales de la filosofía de la escuela nominalista que opera sobre conceptos individualizados y casos empíricos.

Contenido[ocultar] |

[editar] El principio

El principio es atribuido al fraile franciscano inglés del siglo XIV Guillermo de Ockham que forma la base del reduccionismo metodológico. Este principio ya formaba parte de la filosofía medieval aunque fue Ockham quien lo utilizó de forma filosófica. Sin embargo, no solamente es un principio metodológico sino que, además, tiene características gnoseológicas y ontológicas.

|

En su forma más simple, el principio de Ockham indica que las explicaciones nunca deben multiplicar las causas sin necesidad.

|

Esta regla ha tenido una importancia capital en el desarrollo posterior de la ciencia.

[editar] Ejemplo

Alguien se encuentra un billete en el bolsillo. Examinamos 4 posibles explicaciones:

- El billete se lo introdujo un amigo.

- El billete se lo introdujo un amigo para darle una sorpresa.

- El billete se lo introdujo un amigo para darle una sorpresa en agradecimiento por invitarle al cine.

- El billete se lo introdujo un amigo para darle una sorpresa en agradecimiento por invitarle al cine el día anterior.

Se presume la primera opción como válida (mientras no se demuestre que no lo es) porque explica en su totalidad el suceso eliminando variables que reduzcan la probabilidad de que ésta sea cierta. Aunque hay que notar que existen otras explicaciones no consideradas que podrían llegar a ser la opción verdadera, por ejemplo, que el billete lo haya introducido él mismo y lo hubiese olvidado.

[editar] Origen del término

La denominación de navaja de Ockham apareció en el siglo XVI, y con ella se expresaba que mediante ese principio, Ockham "afeitaba como una navaja las barbas de Platón" ya que de su aplicación se obtenía una notable simplicidad ontológica, por contraposición a la filosofía platónica que «llenaba» su ontología de entidades (además de los entes físicos, Platón admitía los entes matemáticos y las ideas). Desde una perspectiva ontológica, pues, la aplicación de este principio permitió a Ockham eliminar muchas entidades, a las que declaró innecesarias. De esta manera se enfrentó a muchas tesis sustentadas por la escolástica y, en especial, rechazó la existencia de las especies sensibles o inteligibles como intermediarias en el proceso del conocimiento, y rechazó también el principio de individuación, al que calificó de especulación vacía e innecesario.

[editar] El principio en las distintas disciplinas

[editar] En derecho

El argumento de la navaja de Ockham no se aplica en derecho por considerar que el número de pruebas o testimonios debe ser lo mayor posible.[cita requerida]

[editar] En economía

En economía, el argumento de la navaja de Ockham se utiliza en la teoría microeconómica del comportamiento del consumidor. Al no ser necesaria la utilidad cardinal, sino sólo la ordinal para explicar su comportamiento, se escoge esta última, por ser la explicación más sencilla de las dos.

[editar] En lingüística

En lingüística, el argumento de la navaja de Ockham fue utilizado para revisar la adecuación explicativa (problema de adquisición del lenguaje) del modelo de Aspectos de una teoría de la sintaxis de la gramática generativa de Noam Chomsky. Siguiendo su postulado, la teoría pasó de sostener la adquisición del lenguaje por medio de un gran número de reglas complejas a explicarlo por la existencia de unos pocos principios parametrizables (principios y parámetros, programa minimalista).

[editar] En teología

En teología, Guillermo afirmó que no es necesario postular más entes de los necesarios:

"[...] en teología, no postular más que aquellos que exija el dogma; en filosofía (metafísica), aquellos que la razón necesite".

[editar] En biología

Algunos creacionistas sostienen que la navaja de Ockham puede ser usada para defender la teoría del creacionismo frente a la evolución. Después de todo, suponer que un Dios lo haya creado todo es aparentemente más simple que la teoría de la evolución.

Sin embargo, defensores de la teoría de la evolución de Darwin afirman que el sencillo algoritmo evolutivo –la selección natural– se basta por sí solo para explicar la evolución sin necesidad de multiplicar las causas, argumentan que la navaja de Ockham sirve pues para hacer innecesarios los llamados "ganchos celestes", es decir, las explicaciones extranaturales de los fenómenos naturales. De este modo, rechazan situar a la entidad más compleja de todas (un Dios omnipotente) en el origen de toda vida en el Universo (o en el origen del propio Universo), al contrario, se busca el principio más simple capaz de generar complejidad, que aunque en un primer momento siguiendo el criterio de Ockham es el que deberíamos preferir para explicar el fenómeno, no por ello inmediatamente comprueba su mayor probabilidad ni su veracidad;[3] tal como se describe en el apartado: Controversia en la parsimonia de la Navaja de Ockham.

[editar] En informática

Ante la creciente complejidad de los equipos y los sistemas de la informática, se ha desarrollado un principio llamado KISS «Keep It Simple, Stupid!» («¡Mantenlo simple, estúpido!»), sobre todo en relación con páginas y portales de internet. A veces, también se traduce como «Keep It Short and Simple» o «Manténlo corto y simple», en tono más formal.

[editar] En estadística

El principio de parsimonia tiene aplicaciones de importancia en el análisis exploratorio de modelos de regresión lineal múltiple. De un conjunto de variables explicativas que forman parte del modelo a estudiar, debe seleccionarse la combinación más reducida y simple posible, teniendo en cuenta la varianza residual, la capacidad de predicción y la multicolinealidad.

[editar] Pensamiento mágico

Por ejemplo, para explicar la caída de una manzana al suelo, podríamos plantear las siguientes explicaciones:

Estas hipótesis explican igualmente el fenómeno, pero el criterio de Ockham nos obliga a presumir que la segunda es la correcta, ya que las demás nos obligarían a asumir una serie de postulados mucho más complicados, como la cuestionable existencia de duendes.

Se ha de tener cuidado en no confundir la complejidad del enunciado con la complejidad de los eventos. En este caso podría enunciarse:

- Unos duendes lo hicieron.

- Una perturbación atmosférica violenta acompañada de aparato eléctrico y viento fuerte, lluvia, nieve o granizo lo hizo.

Aunque hay que notar en este caso, que el criterio de Ockham solo nos muestra el evento que deberíamos preferir para explicar el evento (ni siquiera el más probable) entre una serie seleccionada, pero no nos asegura que hayamos llegado a la respuesta correcta, por ejemplo, en este caso pudo haber sido un suceso no considerado entre los dos seleccionados el que verdaderamente produjo la caída de la manzana; un terremoto quizás.

[editar] Controversia en la parsimonia de la Navaja de Ockham

La Navaja de Ockham no implica la negación de la existencia de ningún tipo de entidad, ni siquiera es una recomendación de que la teoría más simple sea la más válida.[4] Su sentido es que a igualdad de condiciones, sean preferidas las teorías más simples. Otra cuestión diferente serán las evidencias que apoyen la teoría.[5] Así pues, de acuerdo con este principio, una teoría más simple pero menos correcta no debería ser preferida a una teoría más compleja pero más correcta.

Sin embargo, para el filósofo Paul Newall, el punto principal que hace que la Navaja de Ockham sea de poca ayuda, si no explícitamente entorpecedora y detrimente, es que las consecuencias de añadir entidades adicionales son imposibles de establecer a priori. Puesto que la ciencia nunca finaliza, siempre estamos en la posición "antes" y nunca llegamos a la posición "después", que según Niels Böhr era el único momento en el que se podría introducir la navaja de Ockham[6] lo cual, obviamente, ya no es de ninguna ayuda para juzgar de antemano una teoría.

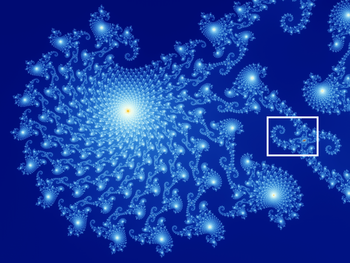

Porque, ¿qué nos hace pensar que el Universo es simple y ordenado, en lugar de complejo y caótico? ¿Y si el Universo y la realidad misma tuvieran una estructura fractal?[7] [8] [9] [10] [11] [12]

Preferir una teoría que explique los datos en función del menor número de causas no parece sensato. ¿Existe algún tipo de razón objetiva para pensar que una teoría así tiene más probabilidades de ser cierta que una teoría menos simple? Aún hoy en día, los filósofos de la ciencia no se ponen de acuerdo en darle una respuesta a esta pregunta.[13]

Su forma moderna es la medida de complejidad, de Kolmogorov. No existe una medida simple de simplicidad. Dadas tres explicaciones, no podemos estar seguros de cuál es la más simple. No es posible aplicar las matemáticas para determinar la validez de un juicio. Se vuelve al juicio subjetivo y relativo.

Por ejemplo, la Física clásica es más simple que las teorías posteriores. Matemáticamente, la física clásica es aquella en cuyas ecuaciones no aparece la constante de Planck. Un paradigma actual principal de la física es que las leyes fundamentales de la naturaleza son las leyes de la física cuántica y la teoría clásica es la aplicación de las leyes cuánticas al mundo macroscópico. Aunque en la actualidad esta teoría es más asumida que probada, uno de los campos de investigación más activos es la correspondencia clásica-cuántica. Este campo de la investigación se centra en descubrir cómo las leyes de la física cuántica producen física clásica dependiendo de que la escala sea al nivel microscópico, mesoscópico o macroscópico de la Realidad.

Sin embargo, lo que aduce la Navaja de Ockham es que la Física clásica no se debería preferir a teorías posteriores y más complejas, como la Mecánica cuántica, puesto que se ha demostrado que la Física clásica está equivocada en algunos aspectos. El primer requerimiento para una teoría es que funcione, que sus predicciones sean correctas y que no haya sido falsada. La Navaja de Ockham se utiliza para distinguir entre teorías que se supone que ya han pasado estas pruebas y aquellas que se encuentran igualmente soportadas por las evidencias.[14]

Otro controvertido aspecto de la Navaja de Ockham es que una teoría puede volverse más compleja en lo relativo a su estructura (o Sintaxis), mientras que su Ontología (o Semántica) se va haciendo más simple, o viceversa.[15] Un ejemplo habitual de esto es la Teoría de la Relatividad.

Galileo Galilei criticó duramente el mal uso de la Navaja de Ockham en su Diálogos sobre los dos máximos sistemas del mundo: ptolemáico y copernicano.La Navaja de Ockham viene representada por el diálogo de Simplicio, un mediocre defensor de la física aristótelica, un personaje con el que quizás Galileo estuviera representando al papa Urbano VIII. El punto clave sobre el que ironizó Galileo fue que si realmente se quisiera comenzar desde un número pequeño de entidades, siempre se podrían considerar las letras del abecedario como entidades fundamentales, puesto que con toda certeza se podría construir todo el conocimiento humano a partir de ellas.

[editar] Anti-navajas de Ockham

La Navaja de Ockham se ha encontrado con multitud de oposiciones por parte de quienes la han considerado demasiado extrema o imprudente. El filósofo Walter of Chatton fue contemporáneo de Guillermo de Occam y quien cuestionó la Navaja de Ockham y el uso que Ockham hizo de ella. Como respuesta, aportó su propia anti-navaja: Si tres cosas no son suficientes para verificar una proposición afirmativa sobre las cosas, una cuarta debe ser añadida, y así sucesivamente.

Otros filósofos que también crearon anti-navajas fueron Leibniz (1646–1716), Immanuel Kant (1724–1804), y Carl Menger (1902-1985). La versión de la anti-navaja de Leibniz tomó su forma en el Principio de plenitud, que establece que Todo lo que sea posible que ocurra, ocurrirá. Leibniz argumentaba que la existencia de el mejor de todos los mundos posibles confirmaría genuinamente cada posibilidad, y postuló en su Teodicea que este mejor de todos los mundos posibles contendría todas las posibilidades, sin que nuestra experiencia finita pudiera cuestionar racionalmente acerca de la perfección de la naturaleza.

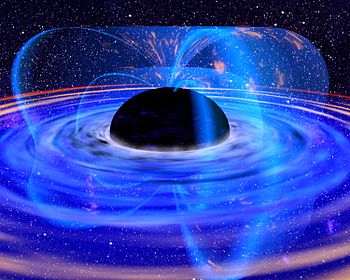

Este mismo Principio de plenitud se encuentra presente en el concepto de Multiverso, en la Teoría de los universos múltiples o Universos paralelos del físico norteamericano Hugh Everett, teorías consideradas como científicas. El reciente descubrimiento de la energía oscura,[16] [17] [18] [19] una suerte de quintaesencia[20] que se podría atribuir al movimiento dinámico de un campo escalar,[21] les ha permitido a los físicos Lauris Baum y Paul Frampton,[22] autor éste en 1974 del primer libro[23] sobre Teoría de cuerdas, formular la existencia de una nueva entidad — contrariamente a lo que la Navaja de Ockham argumentaría —, la energía fantasma,[24] la cual daría lugar a un Modelo cíclico del universo[25] en el que la entropía del Universo decrecería hasta cero,[26] un modelo ya sugerido por Albert Einstein,[27] que explicaría por qué el valor de la Constante cosmológica es varios órdenes de magnitud inferior[28] al que predice la Teoría del Big Bang, inventada ésta por el sacerdote católico Georges Lemaître,[29] pese a ser la comúnmente consensuada por la comunidad científica. Recientemente, algunos científicos han cuestionado incluso una de las asunciones principales de la Física, el supuesto de que las constantes universales sean realmente constantes[30] [31] [32] [33] [34] y sus implicaciones.[35] En el año 2008 se lanzó el satélite Planck Surveyor,[36] que podría permitir dilucidar qué teoría es más adecuada.

Para el filósofo David Kellogg Lewis, considerado uno de los filósofos analíticos más importantes del siglo XX y proponente del realismo modal, existe un número infinito de mundos causalmente aislados y el nuestro es tan sólo uno de ellos. Para Lewis, la Navaja de Ockham, aplicada a objetos abstractos como conjuntos, es, o bien dudosa por principio o simplemente falsa.[37]

Kant también sintió la necesidad de moderar los efectos de la Navaja de Ockham, creando así su propia anti-navaja en su Crítica de la razón pura:

Carl Menger el fundador de la Escuela Austríaca de Economía encontró a los matemáticos demasiado parsimoniosos en lo que respecta a las variables, de modo que formuló su Law Against Miserliness que tomó estas dos formas:

- Las entidades no deben ser reducidas hasta el punto de inadecuación.

- Es vano hacer con menos lo que requiere más.Carl Menger, 1962.[38]

Incluso Albert Einstein también aportó su propia anti-navaja de Ockham:

[editar] Véase también

[editar] Notas y referencias

- ↑ a b c Robert Audi, ed., «Ockham's razor» (en inglés), The Cambridge Dictionary of Philosophy (2nd Edition edición), Cambridge University Press

- ↑ En sus palabras: entia non sunt multiplicanda praeter necessitatem, es decir: "no deben multiplicarse las entidades innecesariamente".[cita requerida]

- ↑ García González, Juan A. (2003). Francisco Oropesa. ed (en Español). Ockham. España: Editex. ISBN 94-9771-085-1.

- ↑ Skeptic's Dictionary

- ↑ Usenet Phyics FAQs

- ↑ Newall, Paul. Ockham’s Razor (2005)

- ↑ Amanda Gefter. New Scientist, 9 de marzo de 2007. Is the Universe a fractal?.

- ↑ D F Roscoe. arXiv:astro-ph/0609432v1. Via Aristotle, Leibnitz and Mach to a Fractal D=2 Universe.

- ↑ J. R. Mureika. J. Cosmol. Astropart. Phys. JCAP05(2007)021. Fractal Holography: a geometric re-interpretation of cosmological large scale structure.

- ↑ Marcelo B. Ribeiro. Gen.Rel.Grav. 33 (2001) 1699-1730. The Apparent Fractal Conjecture: Scaling Features in Standard Cosmologies.

- ↑ Reginald T. Cahill, Christopher M. Klinger, Kirsty Kitto. The Physicist 37 (2000) 191-195. Process Physics: Modelling Reality as Self-Organising Information.

- ↑ Búsqueda en la base de datos PubMed, indexando casi 5000 publicaciones. Investigaciones científicas sobre fractales. Fractals.

- ↑ Okasha, Samir. Philosophy of Science. A very short introduction. p. 33. Oxford University Press. 2002. ISBN 0-19-280283-6

- ↑ "En la actualidad, se cree que el principio de parsimonia es un dispositivo heurístico. No se asume que la teoría más simple es la correcta y que la más compleja es falsa. Por experiencia, a menudo las teorías más complejas son incorrectas. Pero hasta que se pruebe lo contrario, la teoría más compleja debe ser puesta en cuarentena, pero no descartada a la pila de los desechos de la historia hasta que se demuestre que sea falsa".The Skeptic's dictionary

- ↑ "Mientras que estos dos aspectos de la simplicidad se suelen mezclar, es importante tratarlos como distintos. Una de las razones para hacerlo es que habitualmente, las consideraciones sobre parsimonia y elegancia tiran en direcciones diferentes. Postular entidades extra puede permitir que una teoría sea formulada de forma más simple, mientras que reducir la Ontología (semántica) de una teoría puede ser únicamente posible a cambio de pagar el precio de que sintácticamente sea más compleja." Stanford Encyclopedia of Philosophy

- ↑ P. J. E. Peebles and Bharat Ratra (2003). «The cosmological constant and dark energy». Reviews of Modern Physics 75: pp. 559–606. http://www.arxiv.org/abs/astro-ph/0207347.

- ↑ Saul Perlmutter et al. (The Supernova Cosmology Project) (1999). «Measurements of Omega and Lambda from 42 high redshift supernovae». Astrophysical J. 517: pp. 565–86. http://www.arxiv.org/abs/astro-ph/9812133.

- ↑ Adam Riess (1998). «Observational evidence from supernovae for an accelerating universe and a cosmological constant». Astronomical J. 116: pp. 1009–38. http://www.arxiv.org/abs/astro-ph/9805201.

- ↑ D. N. Spergel et al. (WMAP collaboration) (March 2006). Wilkinson Microwave Anisotropy Probe (WMAP) three year results: implications for cosmology. http://lambda.gsfc.nasa.gov/product/map/current/map_bibliography.cfm.

- ↑ Hrvoje, Stefancic. Phys.Rev. D71 (2005) 124036 Dark energy transition between quintessence and phantom regimes.

- ↑ Ivaylo Zlatev, Limin Wang, Paul J. Steinhardt. Phys.Rev.Lett. 82 (1999) 896-899. Quintessence, Cosmic Coincidence, and the Cosmological Constant.

- ↑ Lauris Baum, Paul H. Frampton. Phys.Rev.Lett. 98 (2007) 071301. Turnaround in Cyclic Cosmology

- ↑ Paul H. Frampton (1974). Dual resonance models. ISBN 0-8053-2581-6.

- ↑ Robert R. Caldwell, Marc Kamionkowski, Nevin N. Weinberg. Phys.Rev.Lett. 91 (2003) 071301. Phantom energy and Cosmic Doomsday

- ↑ Lauris Baum and Paul H. Frampton. Phys. Rev. Lett. 98, 071301 (2007) Turnaround in Cyclic Cosmology

- ↑ Lauris Baum, Paul H. Frampton. Phys.Rev.Lett. 98 (2007) 071301. Turnaround in Cyclic Cosmology

- ↑ Steinhardt, Paul J. Albert Einstein Professor in Science, Princeton University; Autor de El Universo cíclico. No Beginning and No End

- ↑ Paul J. Steinhardt, Neil Turok. Science 312 (2006) 1180-1182. Why the cosmological constant is small and positive

- ↑ Lemaître, G. (1931). «The evolution of the universe: discussion». Nature 128: pp. suppl.: 704.

- ↑ Wandelt, Ben. 2Physics.com, July 25, 2007. "Ni siquiera la constancia de las Constantes de la Naturaleza está garantizada". Changing Constants, Dark Energy and the Absorption of 21 cm Radiation

- ↑ Uzan, Jean-Philippe. Rev.Mod.Phys. 75 (2003) 403. The fundamental constants and their variation: observational status and theoretical motivations.

- ↑ Duff, M.J. arXiv:hep-th/0208093v3. Comment on time-variation of fundamental constants.

- ↑ Barrow, John. D. arXiv:astro-ph/9811022v1. Cosmologies with Varying Light-Speed

- ↑ Reginald T. Cahill. Infinite Energy 10 (2005) 28-37. The Speed of Light and the Einstein Legacy: 1905-2005

- ↑ John D. Barrow, The Constants of Nature; From Alpha to Omega – The Numbers that Encode the Deepest Secrets of the Universe, Pantheon Books, New York, 2002, ISBN 0-375-42221-8.

- ↑ Planck Surveyor. European Space Agency

- ↑ David Kellogg Lewis. Philosophical Papers. Vol. II. Oxford University Press, 1987. ISBN 0-19-503646-8

- ↑ Maurer, Armand A., 1962. Medieval Philosophy. New York: Random House. 1984. “Ockham's Razor and Chatton's Anti-Razor.” Mediaeval Studies 46, pp. 463-75.

- ↑ On the Method of Theoretical Physics Conferencia Herbert Spencer, Oxford (10 de Junio de 1993); también publicada en Philosophy of Science, Vol. 1, No. 2 (Abril 1934), pp. 163-169.

0 comentarios